คู่มือฉบับสมบูรณ์สำหรับการปรับใช้ Gonka Miner

- 核心观点:Gonka通过PoW2.0将GPU算力用于AI任务挖矿。

- 关键要素:

- AI推理训练替代无意义哈希计算。

- 算力贡献比例决定奖励分配。

- 信誉系统惩罚作弊鼓励诚实行为。

- 市场影响:推动去中心化AI算力资源市场化。

- 时效性标注:长期影响

คำนำ

ยินดีต้อนรับสู่การเป็นนักขุดบนเครือข่าย AI แบบกระจายศูนย์ของ Gonka! Gonka ใช้กลไกฉันทามติ Proof of Work 2.0 อันล้ำสมัย โดยทุ่มพลังประมวลผลเกือบ 100% ให้กับงานอนุมานและฝึกอบรม AI แทนการแฮชแบบเดิมๆ ของบล็อกเชน ในฐานะนักขุด (โฮสต์) คุณจะได้รับรางวัลจากการมีส่วนร่วมกับพลังประมวลผล GPU พร้อมกับมอบทรัพยากรการประมวลผลอันทรงคุณค่าให้กับระบบนิเวศ AI ทั่วโลก

Gonka Mining คืออะไร?

แนวคิดหลักของการทำเหมืองแร่

- การขุดที่นำทางด้วย AI: GPU ของคุณดำเนินการอนุมาน AI และฝึกอบรมจริง ไม่ใช่การคำนวณที่ไม่มีความหมาย

- กลไกการสปรินต์: เข้าร่วมการแข่งขันการคำนวณแบบจำกัดเวลาและใช้โมเดล Transformer เพื่อทำงานให้สำเร็จ

- น้ำหนักการโหวต: จำนวนการคำนวณที่ประสบความสำเร็จจะกำหนดสิทธิ์การโหวตเครือข่ายและอัตราส่วนการจัดสรรงานของคุณ

- การตรวจสอบแบบสุ่ม: มีเพียง 1-10% ของงานเท่านั้นที่ต้องมีการตรวจสอบ ซึ่งช่วยลดค่าใช้จ่ายได้อย่างมาก

- ระบบชื่อเสียง: พฤติกรรมที่ซื่อสัตย์จะเพิ่มคะแนนชื่อเสียง และพฤติกรรมโกงจะถูกลงโทษอย่างรุนแรง

กลไกการให้รางวัล

- รับรางวัลตามสัดส่วนของการมีส่วนร่วมของพลังการประมวลผล

- ตรวจสอบผลลัพธ์ของผู้อื่นเพื่อรับรางวัลพิเศษ

- พฤติกรรมที่ซื่อสัตย์ในระยะยาวจะมีประสิทธิภาพสูงกว่าและมีการตรวจสอบน้อยลง

- รางวัลการเข้าร่วมการฝึกอบรมแบบกระจายทางภูมิศาสตร์

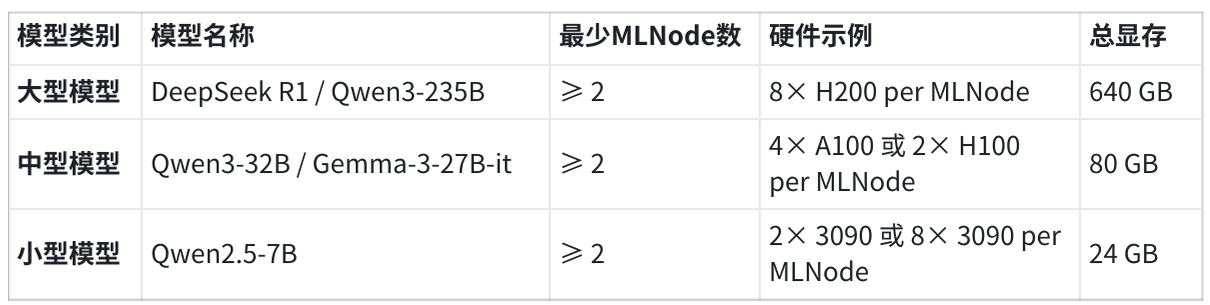

ข้อกำหนดด้านฮาร์ดแวร์

หมวดหมู่รุ่นที่รองรับ

ปัจจุบันโปรโตคอลรองรับหมวดหมู่โมเดลต่อไปนี้:

การกำหนดค่ารางวัลที่เหมาะสมที่สุด

เพื่อให้ได้ผลตอบแทนสูงสุดและรักษาความน่าเชื่อถือ โหนดเครือข่ายแต่ละโหนดควรให้บริการทั้งสามประเภทโมเดล โดยมี MLNode อย่างน้อย 2 รายการต่อประเภท การตั้งค่านี้:

- ปรับปรุงความซ้ำซ้อนในระดับโปรโตคอลและการทนต่อข้อผิดพลาด

- ประสิทธิภาพการตรวจสอบระดับโมเดลที่ได้รับการปรับปรุง

- สอดคล้องกับตรรกะการขยายผลตอบแทนในอนาคต

ข้อกำหนดเซิร์ฟเวอร์ NetworkNode

- ซีพียู: 16 คอร์ (AMD 64)

- หน่วยความจำ: แรม 64+GB

- ที่เก็บข้อมูล: SSD NVMe 1 TB

- เครือข่าย: ขั้นต่ำ 100 Mbps (แนะนำ 1 Gbps)

ข้อกำหนดเซิร์ฟเวอร์ MLNode

- หน่วยความจำ GPU อย่างน้อย 1.5 เท่าของ RAM

- จีพียู 16 คอร์

- ชุดเครื่องมือคอนเทนเนอร์ NVIDIA (CUDA 12.6-12.9)

- NetworkNode และ MLNode สามารถปรับใช้ได้บนเซิร์ฟเวอร์เดียวกัน

พอร์ตเปิด

- 5000: การสื่อสารแบบ P2P ของ Tendermint

- 26657: Tendermint RPC (การสอบถามบล็อคเชน การกระจายธุรกรรม)

- 8000: บริการแอปพลิเคชัน (กำหนดค่าได้)

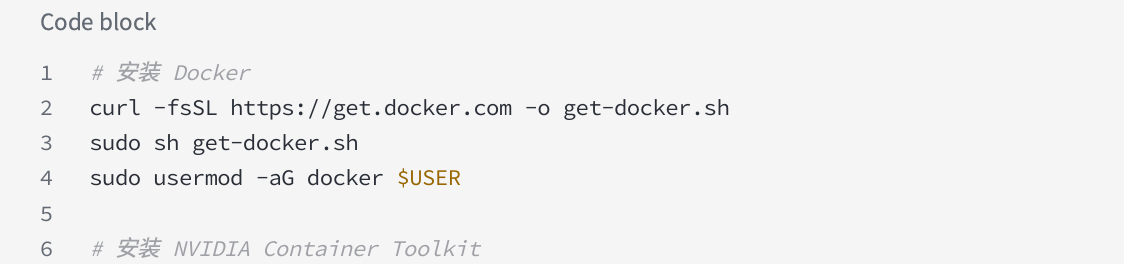

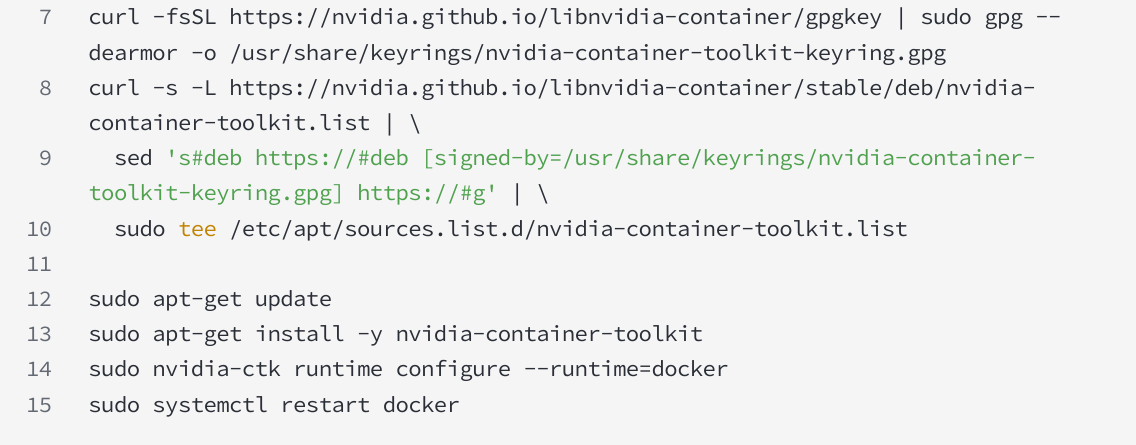

การเตรียมความพร้อมด้านสิ่งแวดล้อม

ติดตั้ง Docker และ NVIDIA Container Toolkit

อูบุนตู/เดเบียน:

ระบบปฏิบัติการ CentOS/RHEL:

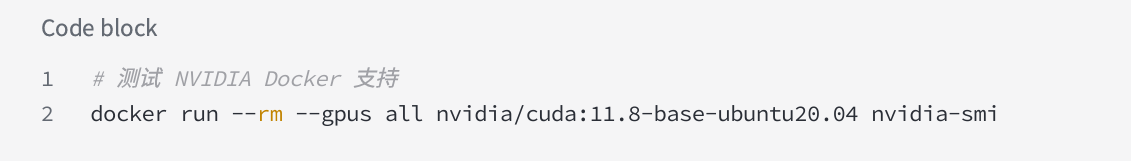

การตรวจสอบการรองรับ GPU

ติดตั้ง HuggingFaceCLI

คู่มือการใช้งาน

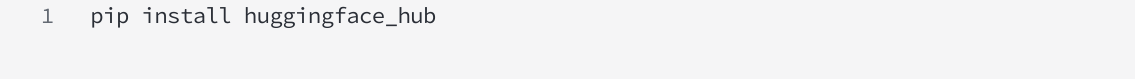

ดาวน์โหลดไฟล์การปรับใช้

ติดตั้งเครื่องมือ CLI บนเครื่องท้องถิ่น

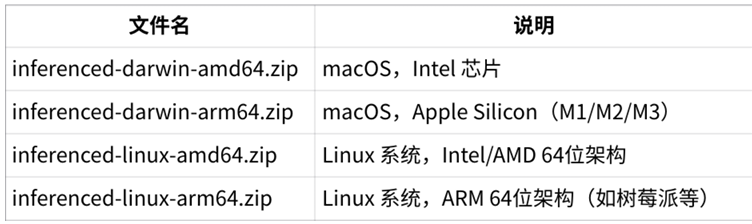

เวอร์ชัน CLI ของเครื่องที่เกี่ยวข้อง

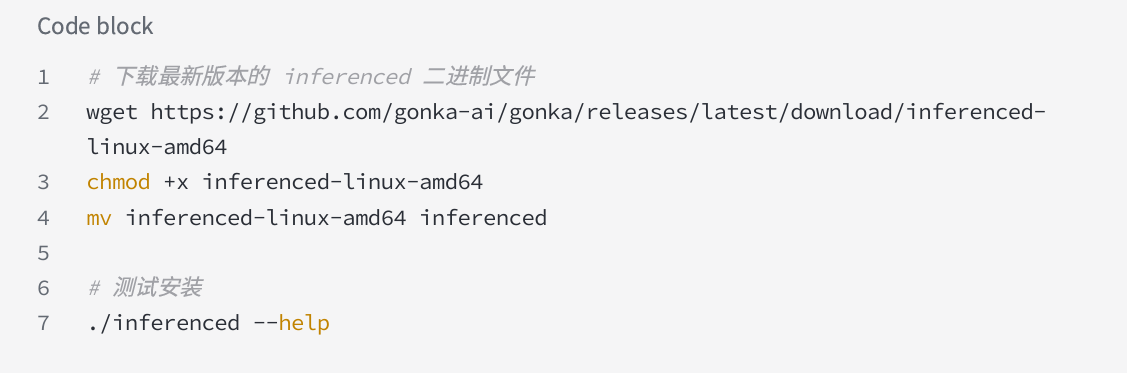

ดาวน์โหลดและติดตั้ง inferencedCLI บน เครื่องท้องถิ่นที่ปลอดภัย ของคุณ (ไม่ใช่เซิร์ฟเวอร์ โดยใช้ LinuxAMD 64 เป็นตัวอย่าง):

หมายเหตุสำหรับผู้ใช้ macOS: บน macOS คุณอาจต้องเปิดใช้งานคุณลักษณะนี้ในการตั้งค่าระบบ → ความเป็นส่วนตัวและความปลอดภัย

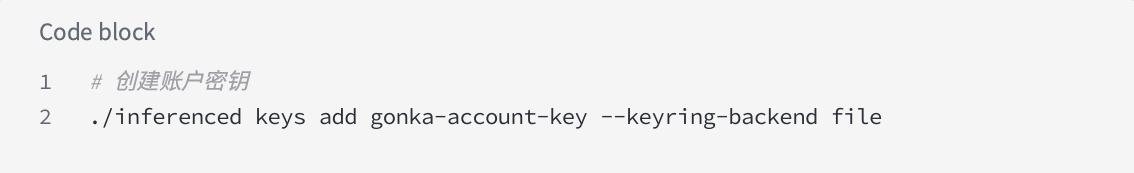

สร้างคีย์บัญชีบนเครื่องท้องถิ่น (กระเป๋าสตางค์เย็น)

⚠สำคัญ: ขั้นตอนนี้จะต้องดำเนินการบนเครื่องท้องถิ่นที่ปลอดภัย (ไม่ใช่เซิร์ฟเวอร์ของคุณ)

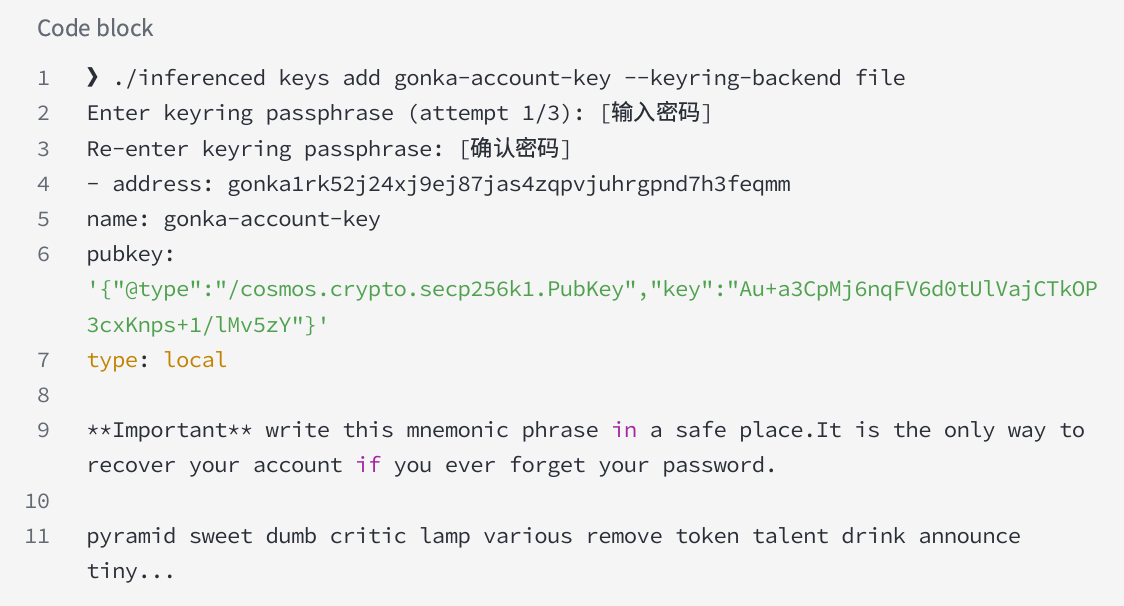

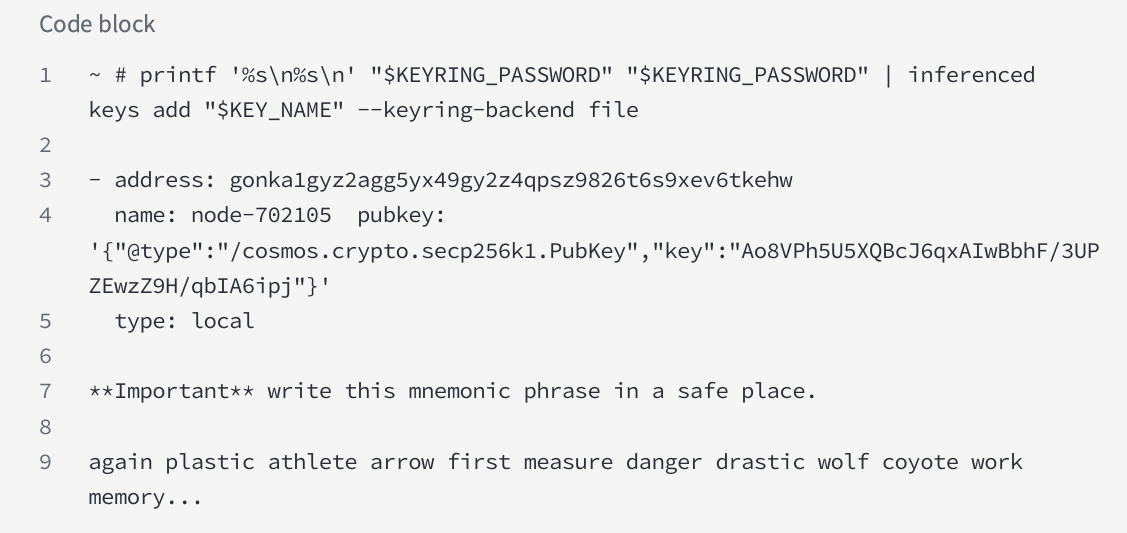

ตัวอย่างผลลัพธ์:

สำคัญอย่างยิ่ง: จดบันทึกวลีการกู้คืนของคุณและเก็บไว้ในที่ปลอดภัยแบบออฟไลน์ นี่เป็นวิธีเดียวที่จะกู้คืนคีย์บัญชีของคุณได้

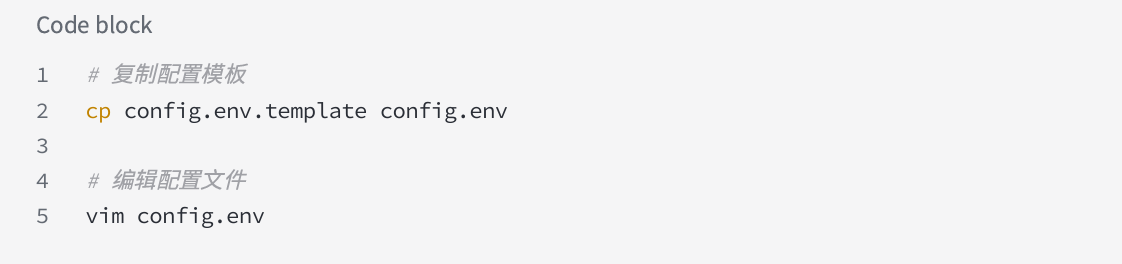

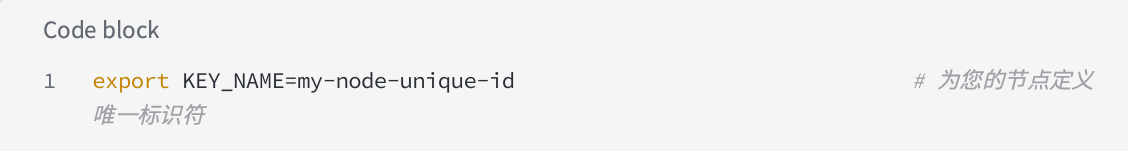

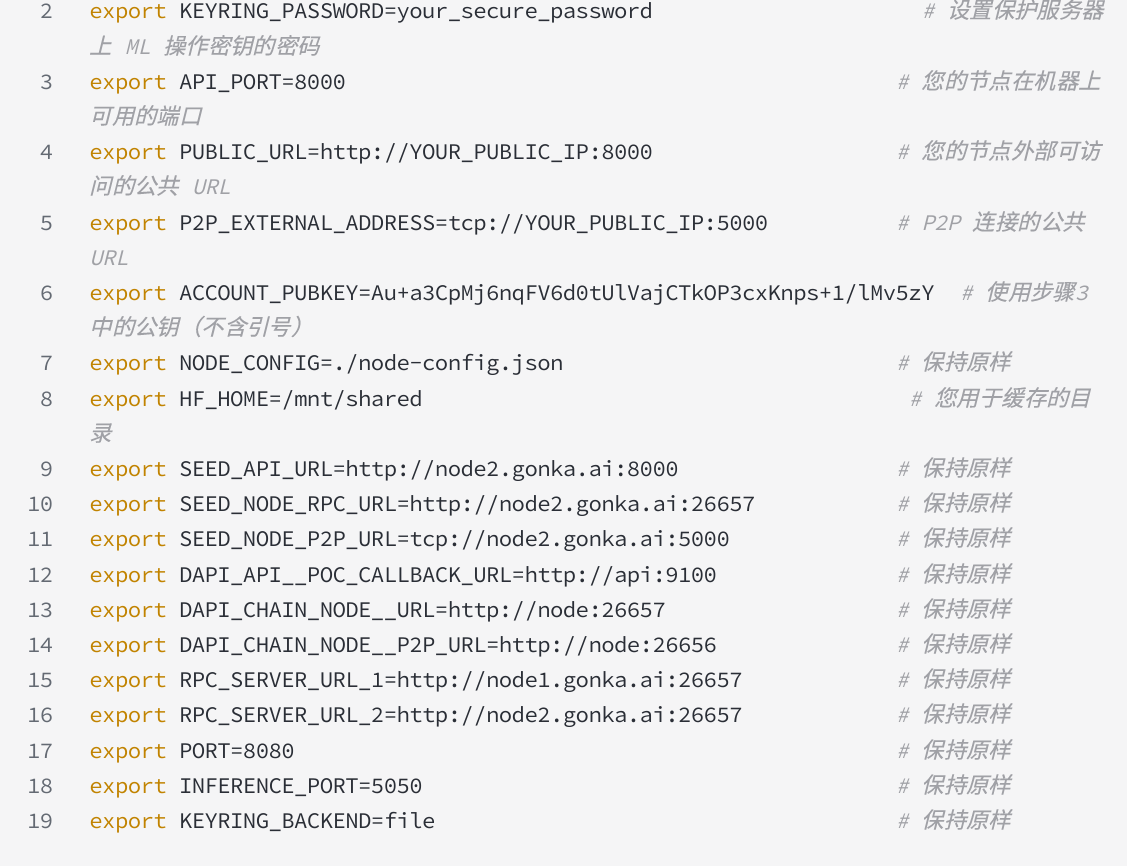

กำหนดค่าตัวแปรสภาพแวดล้อม

กรุณากรอกข้อมูลดังต่อไปนี้:

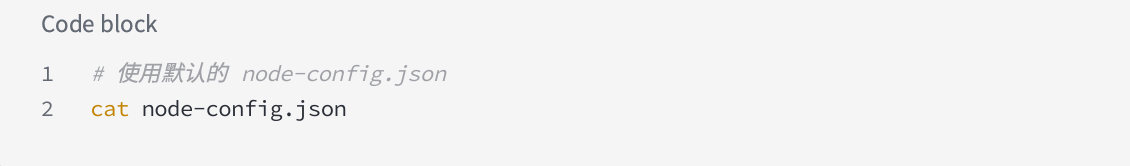

แบบจำลองโหนดการกำหนดค่าเซิร์ฟเวอร์

เลือกการกำหนดค่าที่เหมาะสมตามฮาร์ดแวร์ของคุณ:

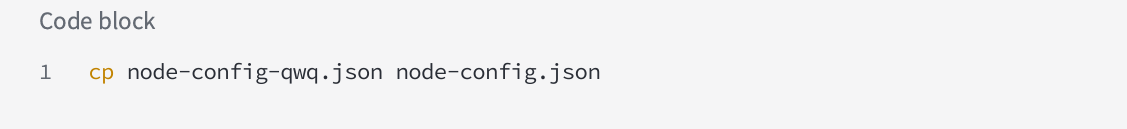

การกำหนดค่ามาตรฐาน (Qwen 2.5-7 B):

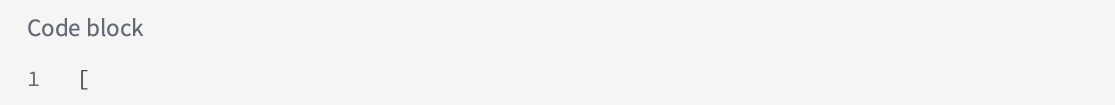

QwQ-32 บอนเอ 100/เอช 100:

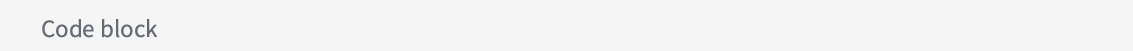

QwQ-32 บอน 4 x 3090:

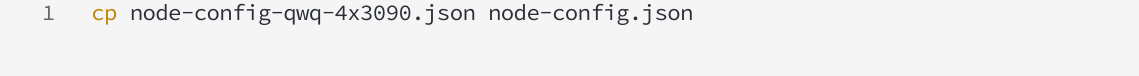

น้ำหนักโมเดลการดาวน์โหลดล่วงหน้าของเซิร์ฟเวอร์

โหนดเริ่มต้นเซิร์ฟเวอร์

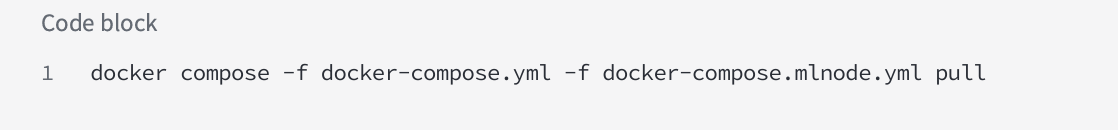

ดึงภาพ Docker

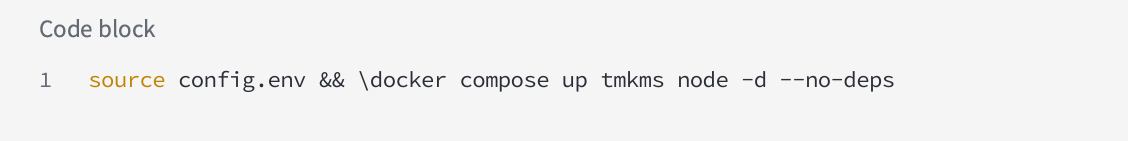

เริ่มการให้บริการเบื้องต้น

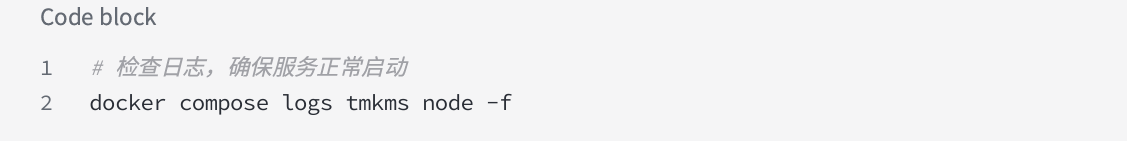

ตรวจสอบการบริการเบื้องต้น:

หากคุณเห็นโหนดโซ่ประมวลผลเหตุการณ์บล็อกอย่างต่อเนื่อง แสดงว่าการตั้งค่าทำงานอย่างถูกต้อง

ตั้งค่าคีย์และลงทะเบียนโฮสต์ให้เสร็จสมบูรณ์

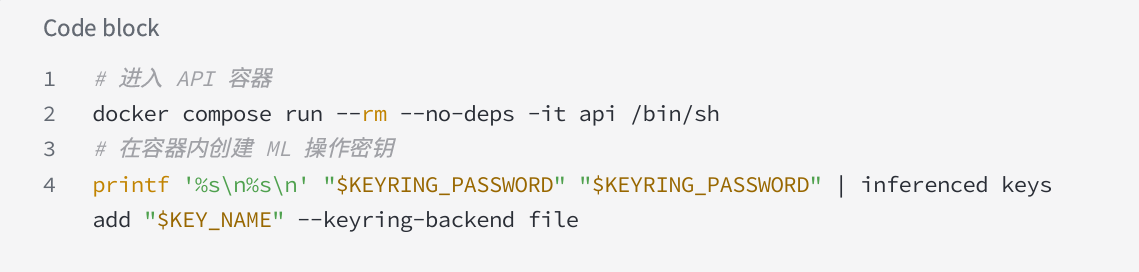

เซิร์ฟเวอร์สร้างคีย์การดำเนินการ ML (กระเป๋าสตางค์ร้อน)

ตัวอย่างผลลัพธ์:

บันทึกที่อยู่คีย์การดำเนินการ ML: gonka1gyz2agg5yx49gy2z4qpsz9826t6s9xev6tkehw

โฮสต์การลงทะเบียนเซิร์ฟเวอร์

ในภาชนะเดียวกัน:

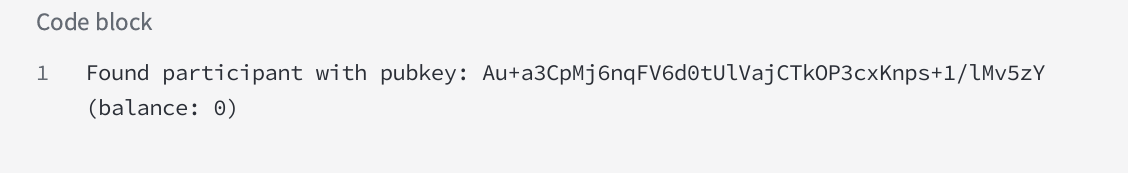

ผลลัพธ์ที่คาดหวัง:

จากนั้นออกจากคอนเทนเนอร์:

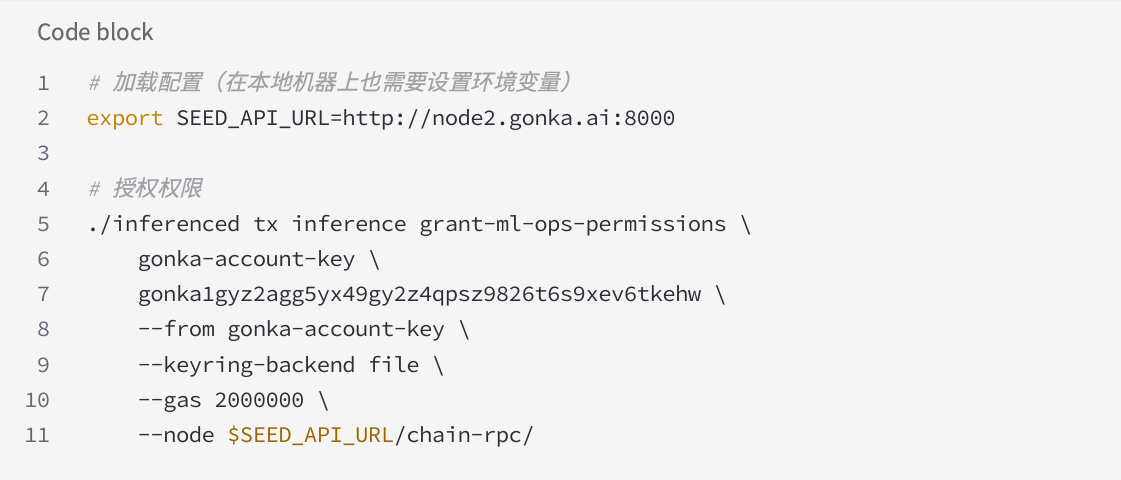

เครื่องในพื้นที่อนุญาตคีย์การดำเนินการ ML

⚠สำคัญ: ดำเนินการขั้นตอนนี้บนเครื่องท้องถิ่นที่ปลอดภัยที่คุณสร้างคีย์บัญชี

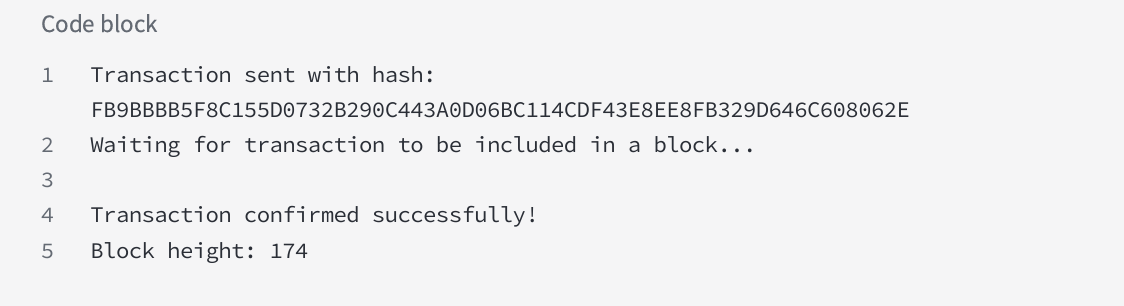

ผลลัพธ์ที่คาดหวัง:

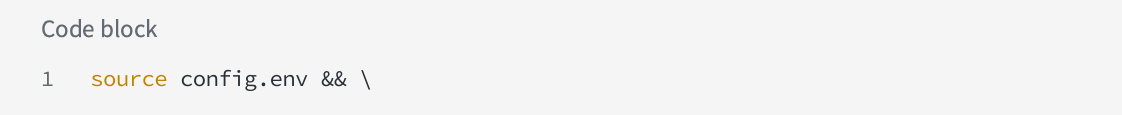

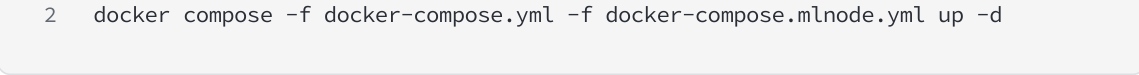

เซิร์ฟเวอร์เริ่มโหนดเต็ม

ตรวจสอบสถานะโหนด

หลังจากรอไม่กี่นาที คุณควรเห็นโหนดของคุณที่ URL ต่อไปนี้:

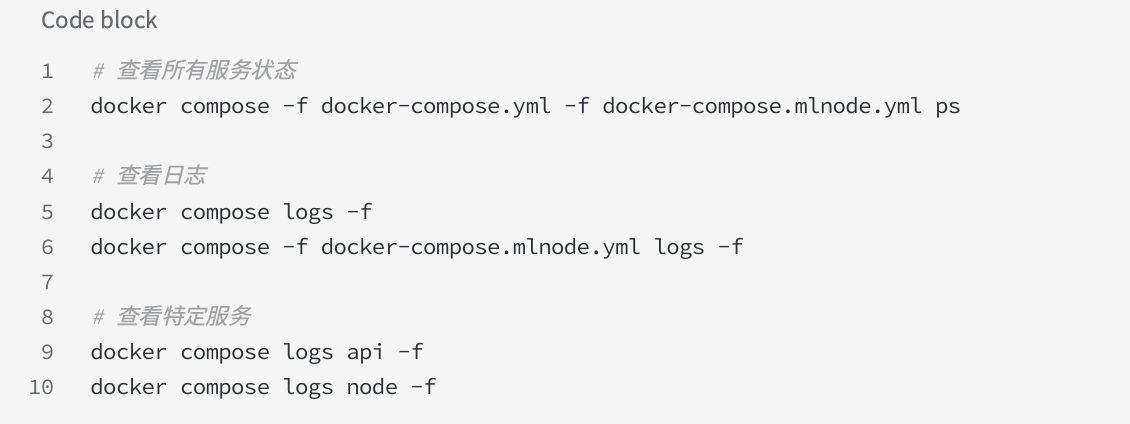

การติดตามและการจัดการ

ตรวจสอบสถานะการบริการ

ตัวบ่งชี้การติดตามที่สำคัญ

1. สถานะการซิงโครไนซ์โหนด: ตรวจสอบการซิงโครไนซ์กับเครือข่าย

2. การใช้ GPU: ตรวจสอบการใช้พลังงานในการประมวลผล

3. สถานะสุขภาพ MLNode: ตรวจสอบให้แน่ใจว่าบริการการอนุมานเป็นปกติ

4. หมายเลขการเชื่อมต่อ P2P: ตรวจสอบสถานะการเชื่อมต่อเครือข่าย

5. ความสูงของบล็อก: รับรองการซิงโครไนซ์กับเครือข่าย

การหยุดและการทำความสะอาดโหนด

วิธีหยุด MLNode

1. ปิดใช้งาน MLNode แต่ละตัว:

2. รอรอบถัดไป: แฟล็กปิดใช้งานจะมีผลหลังจากรอบถัดไปเริ่มต้นเท่านั้น

3. ตรวจสอบการลบ: ยืนยันว่าโหนดไม่อยู่ในรายชื่อผู้เข้าร่วมที่ใช้งานอยู่และน้ำหนักที่มีผลคือ 0

4. หยุด MLNode:

การทำความสะอาดข้อมูล

⚠หมายเหตุ: การลบ $HF_HOME จะต้องดาวน์โหลดไฟล์โมเดลขนาดใหญ่ใหม่อีกครั้ง

การกำหนดค่าขั้นสูง

ตัวอย่างการกำหนดค่าการเพิ่มประสิทธิภาพ GPU หลายตัว

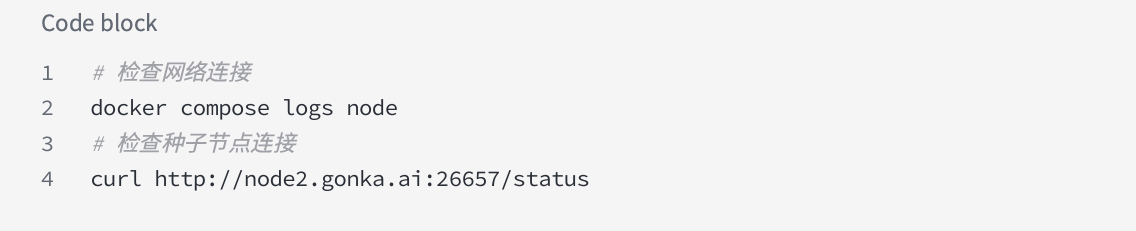

QwQ-32 Bon 8 x 3090 การกำหนดค่า:

เจสัน

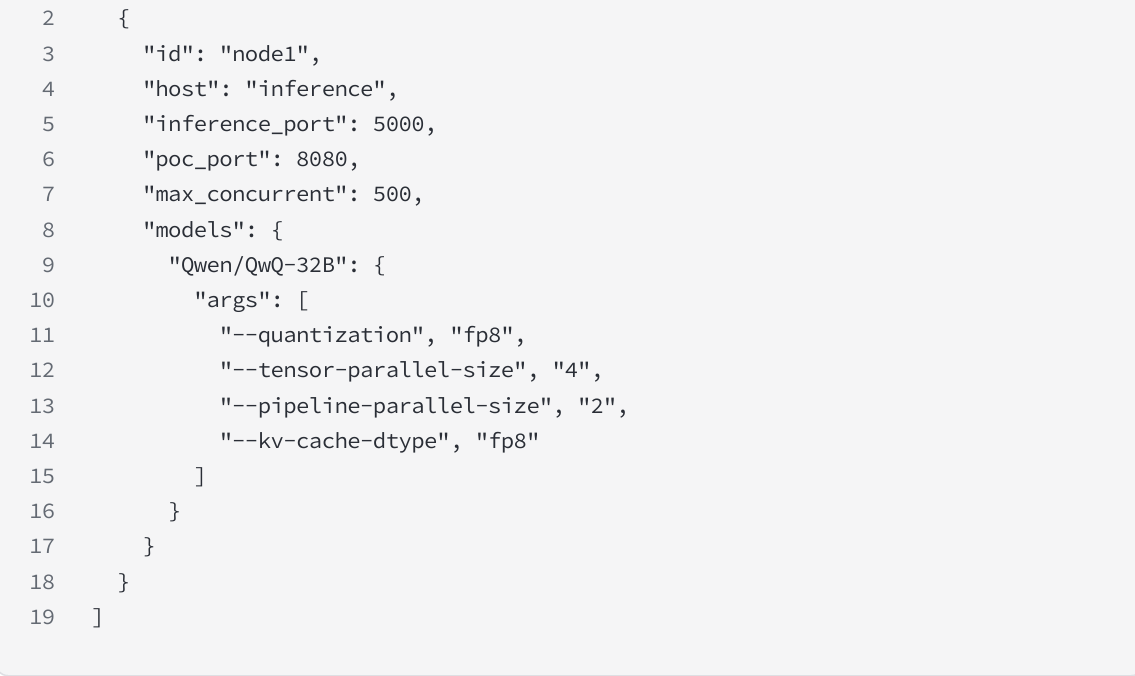

พารามิเตอร์การปรับแต่งประสิทธิภาพ

การแก้ไขปัญหา

คำถามที่พบบ่อย

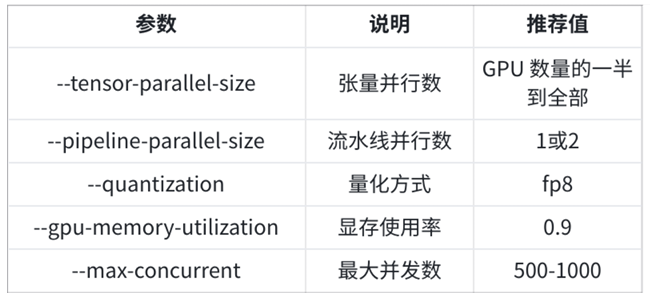

1. การซิงโครไนซ์โหนดล้มเหลว

2. ความล้มเหลวในการเริ่มต้น MLNode

3. การดาวน์โหลดโมเดลล้มเหลว

การสนับสนุนด้านเทคนิค

แหล่งข้อมูลอย่างเป็นทางการ

เว็บไซต์อย่างเป็นทางการ: https://gonka.ai

เอกสารประกอบ: https://gonka.ai/introduction/

ดิสคอร์ด: https://discord.gg/aJDBXt2XJ5

อีเมล: hello@productscience.ai

รับความช่วยเหลือ

หากคุณต้องการความช่วยเหลือ โปรดเข้าร่วมเซิร์ฟเวอร์ Discord ของเราสำหรับคำถามทั่วไป ปัญหาทางเทคนิค หรือคำถามด้านความปลอดภัย

เริ่มต้นการเดินทางการขุดของคุณ!

ขอแสดงความยินดีที่การติดตั้งโหนดขุด Gonka เสร็จสมบูรณ์! ตอนนี้คุณได้กลายเป็นส่วนสำคัญของเครือข่าย AI แบบกระจายศูนย์แล้ว การมีส่วนร่วมกับพลังประมวลผล GPU ของคุณไม่เพียงแต่จะได้รับรางวัลจากการขุดเท่านั้น แต่ยังช่วยพัฒนา AI ระดับโลกอีกด้วย

อย่าลืมดูแลให้โหนดของคุณทำงานอย่างเสถียรและมีส่วนร่วมในกิจกรรมเครือข่ายอย่างซื่อสัตย์ ชื่อเสียงและรายได้ของคุณจะเพิ่มขึ้นเรื่อยๆ ขอให้สนุกกับการขุด!

บทช่วยสอนนี้อ้างอิงจากเอกสารอย่างเป็นทางการ หากมีข้อสงสัย โปรดดูเอกสารอย่างเป็นทางการฉบับล่าสุดหรือติดต่อฝ่ายสนับสนุนด้านเทคนิค

เกี่ยวกับ Gonka.ai

Gonka คือเครือข่ายแบบกระจายศูนย์ที่ออกแบบมาเพื่อมอบพลังการประมวลผล AI ที่มีประสิทธิภาพ เป้าหมายการออกแบบคือการเพิ่มประสิทธิภาพการใช้พลังการประมวลผล GPU ทั่วโลกให้สูงสุดเพื่อจัดการเวิร์กโหลด AI ที่สำคัญ ด้วยการขจัดระบบเกตเวย์แบบรวมศูนย์ Gonka จึงช่วยให้นักพัฒนาและนักวิจัยเข้าถึงทรัพยากรการประมวลผลได้โดยไม่ต้องขออนุญาต ขณะเดียวกันก็มอบโทเค็น GNK ดั้งเดิมให้กับผู้เข้าร่วมทุกคน

Gonka ได้รับการบ่มเพาะโดย Product Science Inc. ผู้พัฒนา AI สัญชาติอเมริกัน ก่อตั้งโดยพี่น้องตระกูล Liberman ผู้คร่ำหวอดในวงการ Web 2 และอดีตผู้อำนวยการฝ่ายผลิตภัณฑ์หลักของ Snap Inc. บริษัทประสบความสำเร็จในการระดมทุน 18 ล้านดอลลาร์ในปี 2023 จากนักลงทุน ได้แก่ Coatue Management ซึ่งเป็นนักลงทุนใน OpenAI, Slow Ventures ซึ่งเป็นนักลงทุนใน Solana, K5, Insight และ Benchmark Partners ผู้ร่วมก่อตั้งโครงการในช่วงแรก ๆ ได้แก่ ผู้นำที่มีชื่อเสียงในวงการ Web 2-Web 3 เช่น 6 Blocks, Hard Yaka, Gcore และ Bitfury

เว็บไซต์อย่างเป็นทางการ | Github | X | Discord | เอกสารเผยแพร่ | แบบจำลองเศรษฐกิจ | คู่มือผู้ใช้