原題:「仮想通貨とAIの交差点を理解する」

原作者: ルーカス・チェヤン

オリジナルコンピレーション: Rhythm Workers、BlockBeats

目次

導入

中心となる概念の用語の説明

人工知能 + 暗号通貨のパノラマ

分散型コンピューティング

概要

分散型コンピューティング

垂直フィールド

一般的なコンピューティング

流通市場

分散型機械学習トレーニング

分散型汎用人工知能

AI モデル用の分散コンピューティング スタックを構築する

その他の分散型製品

見通し

スマート コントラクトとゼロ知識機械学習 (zkML)

ゼロ知識機械学習 (zkML)

インフラストラクチャとツール

コプロセッサ

応用

見通し

人工知能エージェント

代理店プロバイダー

ビットコインとAIエージェント

見通し

結論は

導入

ブロックチェーンの出現は、おそらくコンピューター サイエンスの歴史の中で最も重要な進歩の 1 つです。同時に、人工知能の発展は私たちの世界に大きな影響を与えるでしょうし、すでに影響を及ぼしています。ブロックチェーン技術が取引決済、データストレージ、システム設計に新たなパラダイムを提供するとすれば、人工知能はコンピューティング、分析、コンテンツ制作における革命となる。両方の業界のイノベーションにより、今後数年間で両方の採用が加速する可能性のある新しい使用例が生み出されています。このレポートは、仮想通貨と人工知能の統合を調査し、両者の間のギャップを埋め、両方の力を活用しようとする新しいユースケースに焦点を当てています。具体的には、このレポートでは、分散コンピューティング プロトコル、ゼロ知識機械学習 (zkML) インフラストラクチャ、および人工知能エージェントのプロジェクトを調査します。

暗号通貨は、人工知能にパーミッションレス、トラストレスの構成可能な決済層を提供します。これにより、分散型コンピューティング システムを通じてハードウェアをよりアクセスしやすくしたり、価値交換を必要とする複雑なタスクを実行できる人工知能エージェントを構築したり、Sybil 攻撃やディープフェイク テクノロジー (ディープフェイク) に対抗するための ID および来歴ソリューションを開発したりするなど、より多くのユース ケースが可能になります。 Web 2 ですでに見られたように、人工知能は暗号通貨に多くの利点をもたらします。これには、ChatGPT や特別にトレーニングされたバージョンの Copilot などの大規模な言語モデルを通じたユーザーと開発者のユーザー エクスペリエンス (UX) の強化、およびスマート コントラクトの機能と自動化を大幅に改善する可能性が含まれます。ブロックチェーンは、人工知能に必要な透明でデータが豊富な環境です。しかし、ブロックチェーンの計算能力にも限界があり、これが人工知能モデルを直接統合する上での大きな障害となっています。

暗号通貨と人工知能の交差点における進行中の実験と最終的な採用の背後にある原動力は、まさに暗号通貨の最も有望なユースケースの多くを推進しているものであり、価値の移転をより容易にするパーミッションレスでトラストレスなオーケストレーション層です。その巨大な可能性を考えると、この分野のプレーヤーは、これら 2 つのテクノロジーがどのように交差するかという基本的な方法を理解する必要があります。

核となるアイデア:

近い将来 (6 か月から 1 年)、暗号通貨と AI の統合は、開発者の効率、スマート コントラクトの監査可能性とセキュリティ、ユーザーの説明責任を向上させる AI アプリケーションによって支配されるでしょう。これらの統合は暗号通貨固有のものではありませんが、オンチェーンの開発者とユーザーのエクスペリエンスを向上させます。

高性能 GPU が深刻に不足しているのと同様に、分散コンピューティング製品は AI にカスタマイズされた GPU 製品を開発しており、その導入を強力にサポートしています。

ユーザーエクスペリエンスと規制は、分散型コンピューティングの顧客にとって依然として障壁となっています。しかし、OpenAI の最近の発展と米国で進行中の規制の監視により、許可不要で検閲に耐性のある分散型人工知能ネットワークの価値提案が浮き彫りになっています。

オンチェーン AI 統合、特に AI モデルを使用できるスマート コントラクトには、オフチェーン計算を検証する zkML テクノロジーやその他の計算方法の改善が必要です。包括的なツールと開発人材の不足、および高いコストが導入の障壁となっています。

AI エージェントは暗号通貨に最適であり、ユーザー (またはエージェント自体) が他のサービス、エージェント、または個人と取引するためのウォレットを作成できます。これは現在、従来の金融チャネルでは達成できません。より広く採用するには、非暗号化製品との追加の統合が必要です。

用語の説明:

人工知能 (Artificial Intelligence) は、コンピューティングと機械を使用して、人間の推論と問題解決能力を模倣します。

ニューラル ネットワークは、AI モデルのトレーニング方法です。一連のアルゴリズム層を通じて入力データを処理し、目的の出力が生成されるまで継続的に最適化します。ニューラル ネットワークは、出力を変更するために変更できる変更可能な重みを持つ方程式で構成されます。出力が正確であることを保証するために、トレーニングに大量のデータと計算が必要になる場合があります。これは、AI モデルを開発する最も一般的な方法の 1 つです (たとえば、ChatGPT は、Transformer ベースのニューラル ネットワーク プロセスを使用します)。

トレーニングは、ニューラル ネットワークやその他の AI モデルを開発するプロセスです。入力を正しく解釈し、正確な出力を生成するようにモデルをトレーニングするには、大量のデータが必要です。トレーニング プロセス中、モデル方程式の重みは、満足のいく出力が生成されるまで継続的に変更されます。トレーニング費用は非常に高額になる場合があります。たとえば、ChatGPT はデータを処理するために数万の GPU を使用します。リソースが少ないチームは、アマゾン ウェブ サービス、Azure、Google Cloud プロバイダーなどの専用コンピューティング プロバイダーに依存することがよくあります。

推論は、AI モデルを実際に使用して出力または結果を取得するプロセスです (たとえば、ChatGPT を使用してこのレポートのアウトラインを作成します)。推論はトレーニング中と最終製品の両方で使用されます。計算コストが高いため、トレーニングが完了した後でも実行するとコストが高くなる可能性がありますが、トレーニングよりも計算量は少なくなります。

Zero Knowledge Proofs (ZKP) を使用すると、基礎となる情報を明らかにすることなく主張を検証できます。これは、暗号通貨における 2 つの主な目的、1. プライバシーと 2. スケーラビリティに役立ちます。プライバシーの観点から、これによりユーザーはウォレット内のETHの量などの機密情報を明らかにすることなく取引を行うことができます。スケーラビリティの観点から、計算を再実行することなく、オフチェーンの計算をオンチェーンでより高速に証明できるようになります。これにより、ブロックチェーンとアプリケーションはオフチェーンで計算を実行し、それをオンチェーンで検証できるようになります。

人工知能 + 暗号通貨のパノラマ

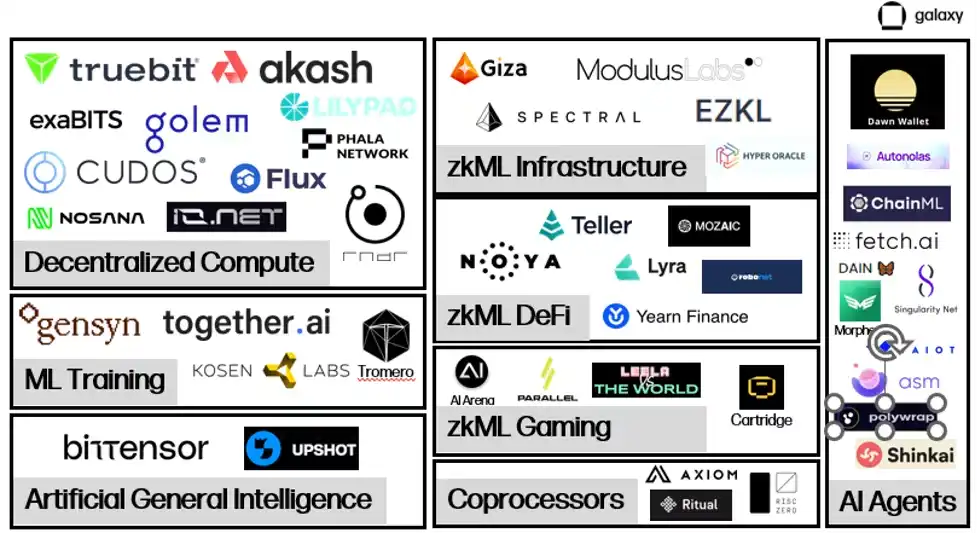

AI と暗号通貨が交わるプロジェクトでは、オンチェーン AI インタラクションを大規模にサポートするために必要なインフラストラクチャを開発中です。

人工知能モデルのトレーニングと推論のために、大量の物理ハードウェア、主に GPU を提供する分散型コンピューティング市場が出現しつつあります。これらの両面市場は、コンピューティング リソースを借りる人と借りようとする人を結びつけ、価値の移転と計算の検証を容易にします。分散型コンピューティング内では、追加の機能を提供するいくつかのサブカテゴリが出現しています。このレポートでは、両面市場に加えて、検証可能なトレーニングと出力の微調整を専門とする機械学習トレーニング プロバイダーと、一般人工知能 (人工知能とも呼ばれる) を実現するために計算とモデル生成を接続することに特化したプロジェクトについても調査します。インテリジェントなインセンティブ ネットワーク。

zkML は、検証可能なモデル出力をコスト効率よくタイムリーにオンチェーンで提供することに重点を置いた分野です。これらのプロジェクトは主に、アプリケーションがオフチェーンで大量の計算リクエストを処理し、検証可能な出力をオンチェーンで公開して、オフチェーンの作業が完全かつ正確であることを証明できるようにします。 zkML は現在のインスタンスでは高価で時間がかかりますが、ソリューションとして使用されることが増えています。これは、AI モデルを活用したい zkML プロバイダーと DeFi/ゲームとの間の統合の数が増加していることからも明らかです。

コンピューティング リソースが豊富に供給され、オンチェーンで計算を検証できるため、オンチェーン AI エージェントへの扉が開かれます。エージェントは、ユーザーに代わってリクエストを実行するようにトレーニングされたモデルです。エージェントは、オンチェーン エクスペリエンスを大幅に強化する素晴らしい機会を提供し、ユーザーがチャットボットと会話することで複雑なトランザクションを実行できるようにします。ただし今のところ、エージェント プロジェクトは引き続き、簡単かつ迅速な展開を可能にするインフラストラクチャとツールの開発に重点を置いています。

分散型コンピューティング

概要

人工知能は、モデルのトレーニングと推論の実行の両方に大規模なコンピューティング リソースを必要とします。過去 10 年間で、モデルがより複雑になるにつれて、計算需要が飛躍的に増大しました。たとえば、OpenAI は、2012 年から 2018 年の間に、モデルの計算要件が 2 年ごとの 2 倍から 3 か月半ごとの 2 倍に増加したことを発見しました。これにより、GPU の需要が急増し、一部の仮想通貨マイナーは GPU を活用してクラウド コンピューティング サービスを提供しています。コンピューティング リソースへのアクセスをめぐる競争が激化しコストが上昇する中、いくつかのプロジェクトが暗号通貨を活用して分散型コンピューティング ソリューションを提供しています。オンデマンド コンピューティングを競争力のある価格で提供するため、チームはモデルのトレーニングと実行を行う余裕が得られます。場合によっては、パフォーマンスとセキュリティがトレードオフになる場合があります。

Nvidia が製造する最先端の GPU などのハイエンド ハードウェアの需要は高いです。 9月、TetherはドイツのビットコインマイナーであるNorthern Dataの株式を取得し、伝えられるところによると、AIトレーニングに使用される最先端のGPUの1つである10,000台のH 100 GPUを取得するために4億2,000万ドルを支払った。最適なハードウェアを入手するまでの待ち時間は少なくとも 6 か月、多くの場合それ以上かかります。さらに悪いことに、企業は、使用すらしないコンピューティング リソースを購入するために長期契約を結ぶことを求められることがよくあります。これにより、コンピューティング リソースが存在しても市場で入手できない状況が発生する可能性があります。分散型コンピューティング システムは、コンピューティング リソースの所有者がいつでも競争力のある価格で余剰リソースをレンタルできる二次市場を作成することで、市場の非効率性を解決し、新たな供給を解放します。

競争力のある価格設定とアクセスしやすさに加えて、分散型コンピューティングの重要な価値は検閲への耐性です。最先端の人工知能開発は、比類のないコンピューティング能力とデータへのアクセスを持つ大手テクノロジー企業によってますます支配されています。 2023 年の AI インデックス年次報告書で初めて強調された重要なテーマの 1 つは、AI モデルの開発に関して、産業界が学界を超えて少数のテクノロジー リーダーの手に管理を集中させようとしているということです。このことは、特にこれらのハイテク企業が制御できないAIの開発を制限する規制措置を推進していることを受けて、AIモデルの基盤となる規範や価値観の形成において彼らが多大な影響力を持つことができるのではないかという懸念を引き起こしている。

分散型コンピューティングの垂直分野

近年、いくつかの分散コンピューティング モデルが登場しましたが、それぞれに独自の重点とトレードオフがあります。

一般的なコンピューティング

Akash、io.net、iExec、Cudos などのプロジェクトは、データや一般的なコンピューティング ソリューションに加えて、AI のトレーニングと推論専用の特定のコンピューティング リソースも提供するか、まもなく提供される分散型コンピューティング アプリケーションです。

Akash は現在、唯一の完全にオープンソースの「スーパー クラウド」プラットフォームです。 Cosmos SDKを使用したPoSネットワークです。 Akash のネイティブ トークンである AKT は、ネットワークを保護し、支払い形式として機能し、参加を奨励するために使用されます。 Akash は、パーミッションレス クラウド コンピューティング マーケットプレイスの提供に重点を置いて 2020 年に最初のメインネットを立ち上げ、当初はストレージと CPU のレンタル サービスを提供していました。 2023 年 6 月に、Akash は GPU に焦点を当てた新しいテストネットを立ち上げ、9 月には GPU メインネットを立ち上げ、ユーザーが AI トレーニングと推論のために GPU をレンタルできるようにしました。

Akash エコシステムには、テナントとプロバイダーという 2 つの主要なアクターがいます。テナントは、コンピューティング リソースを購入したい Akash ネットワークのユーザーです。プロバイダーはコンピューティング リソースのプロバイダーです。テナントとプロバイダーをマッチングするために、Akash は逆オークション プロセスを利用しています。テナントはコンピューティングのニーズを提出し、サーバーの場所やコンピューティングを実行するハードウェアの種類、支払ってもよい金額などの特定の条件を指定できます。その後、プロバイダーが希望価格を提示し、最も低い入札者がタスクを取得します。

Akash バリデーターはネットワークの整合性を維持します。バリデータ セットは現在 100 に制限されていますが、時間の経過とともに徐々に増加する予定です。現在最小額をステーキングしているバリデーターよりも多くの AKT をステーキングすることで、誰でもバリデーターになることができます。 AKT 保有者は、AKT をバリデーターに委任することもできます。ネットワークの取引手数料とブロック報酬は AKT で分配されます。さらに、Akash ネットワークはリースごとにコミュニティが決定した料金で「手数料」を請求し、それを AKT 保有者に分配します。

流通市場

分散型コンピューティング市場は、既存のコンピューティング市場の非効率性を埋めることを目的としています。供給の制約により、企業は必要以上のコンピューティング リソースを備蓄することになりますが、クラウド サービス プロバイダーとの契約形態により供給はさらに制限されます。これらの顧客は、継続的な使用が必要ない場合でも、長期契約に固定されています。分散型コンピューティング プラットフォームにより、新たな供給が可能になり、コンピューティング リソースを必要とする世界中の誰もがプロバイダーになれるようになります。

AI トレーニング用の GPU の需要の急増が、Akash ネットワークの長期使用につながるかどうかは不明です。 Akash は長い間、CPU のマーケットプレイスを提供してきており、たとえば、集中型の代替品と同様のサービスを 70 ~ 80% 割引で提供しています。しかし、価格が低いため大幅な普及には至りませんでした。ネットワーク上のリース活動は横ばいで、2023 年第 2 四半期の平均コンピューティング リソース使用率はわずか 33%、メモリ使用率は 16%、ストレージ使用率は 13% でした。これらはオンチェーン導入における印象的な指標ですが (参考までに、大手ストレージプロバイダーである Filecoin の 2023 年第 3 四半期のストレージ使用率は 12.6% でした)、供給が引き続きこれらの製品の需要を上回っていることを示しています。

Akash が GPU ネットワークを立ち上げてからまだ半年余りですが、その長期的な普及を正確に測定するには時期尚早です。需要の兆候として、GPU 使用率はこれまで平均 44% であり、CPU、メモリ、ストレージを上回っています。これは主に、A 100 などの最高品質の GPU に対する需要によって推進されており、高品質 GPU の 90% 以上がすでにリースされています。

Akash の 1 日あたりの支払い額も増加し、GPU の出現前のほぼ 2 倍になりました。これは、他のサービス、特に CPU の使用量の増加が部分的に原因ですが、主に新しい GPU によるものです。

価格は Lambda Cloud や Vast.ai などの一元化された競合他社と同等 (場合によってはさらに高価) です。 H 100 や A 100 などのハイエンド GPU に対する大きな需要は、デバイスの所有者のほとんどが、競争力のある価格設定に直面している市場で発売することにほとんど関心がないことを意味します。

最初の興奮にもかかわらず、採用には依然として障壁があります (後述)。分散型コンピューティング ネットワークは、需要と供給を生み出すためにさらに多くのことを行う必要があり、チームは新しいユーザーをよりうまく引きつける方法を実験中です。たとえば、2024 年初頭、Akash は、GPU プロバイダーからの AKT のリリースを増やし、特にハイエンド GPU をターゲットとして、より多くの供給を奨励する提案 240 を可決しました。チームはまた、ネットワークのリアルタイム機能を潜在的なユーザーに実証するための概念実証モデルの立ち上げにも取り組んでいます。 Akash は独自の基本モデルをトレーニングしており、Akash GPU を使用して出力を生成するチャットボットと画像生成製品を発売しました。同様に、io.net は安定した普及モデルを開発し、従来の GPU データ センターのパフォーマンスと規模をより適切にシミュレートする新しいネットワーク機能を展開しています。

分散型機械学習トレーニング

人工知能のニーズを満たす汎用コンピューティング プラットフォームに加えて、機械学習モデルのトレーニングに重点を置いた一連の専用 AI GPU プロバイダーが登場しています。たとえば、Gensyn氏は「集合知を構築するために電力とハードウェアを調整」しており、「誰かが何かを訓練したいと思っていて、誰かがそれを訓練する意欲があるのであれば、訓練は許可されるべきだ」と主張している。

プロトコルには、提出者、解決者、検証者、内部告発者の 4 つの主な役割があります。送信者は、トレーニング リクエストを含むタスクをネットワークに送信します。これらのタスクには、トレーニング目標、トレーニング対象のモデル、トレーニング データが含まれます。提出プロセスの一環として、提出者はソルバーの推定計算コストをカバーするために前払い料金を支払います。

送信されると、タスクはソルバーに割り当てられ、ソルバーがモデルの実際のトレーニングを実行します。次に、ソルバーは完了したタスクを検証者に送信します。検証者は、トレーニングが正しく完了したかどうかを確認する責任を負います。内部告発者には、バリデーターが誠実に行動することを保証する責任があります。内部告発者にネットワークへの参加を促すため、Gensyn は意図的なバグの証拠を定期的に提供し、内部告発者がバグを捕らえた場合に報酬を与えることを計画しています。

AI 関連の作業にコンピューティングを提供することに加えて、Gensyn の重要な価値は、まだ開発中の検証システムです。検証は、GPU プロバイダーによって実行された外部計算が正しいことを確認する (つまり、ユーザーのモデルが希望どおりにトレーニングされていることを確認する) ために必要です。 Gensyn は、「確率的学習証明、グラフベースの測位プロトコル、Truebit スタイルのインセンティブ ゲーム」と呼ばれる新しい検証方法を活用して、この問題を解決する独自のアプローチを採用しています。これは楽観的解決モードであり、検証者は、コストがかかり非効率的なプロセスであるモデルを完全に再実行することなく、ソルバーがモデルを正しく実行したことを確認できます。

Gensyn は、革新的な検証アプローチに加えて、集中型の代替手段や暗号通貨の競合他社と比較して費用対効果が高いとも主張しており、AWS よりも最大 80% 安価に ML トレーニングを提供し、テストでは同様のプロジェクト Truebit を上回っています。

これらの予備的な結果が分散型ネットワークで大規模に再現できるかどうかはまだわかりません。 Gensyn は、小規模データセンター、一般ユーザー、さらには将来的には携帯電話などの小型モバイルデバイスなどのプロバイダーの余剰コンピューティングリソースを活用したいと考えています。ただし、Gensyn チーム自身も認めているように、異種コンピューティング プロバイダーに依存すると、いくつかの新たな課題が生じます。

Google Cloud や Coreweave などの集中型プロバイダーの場合、コンピューティングは高価ですが、コンピューティング間の通信 (帯域幅とレイテンシー) は安価です。これらのシステムは、ハードウェア間の通信を可能な限り迅速に行えるように設計されています。 Gensyn はこのフレームワークをひっくり返し、世界中の誰もが GPU をプロビジョニングできるようにすることで計算コストを削減しますが、ネットワークが遠隔地にある分散型の異種ハードウェア間で計算ジョブを調整する必要があるため、通信コストが増加します。 Gensyn はまだリリースされていませんが、分散型機械学習トレーニング プロトコルを構築するときに何が可能かを示しています。

分散型汎用人工知能

分散型コンピューティング プラットフォームは、人工知能の作成方法における設計の可能性への扉も開きます。 Bittensor は、Substrate 上に構築された分散コンピューティング プロトコルで、「人工知能を協調的なアプローチにどのように変換するか?」という質問に答えようとします。 Bitensor は、人工知能の生成を分散化してコモディティ化することを目指しています。 2021 年に開始されたこのプロトコルは、協調的な機械学習モデルの力を利用して継続的に反復し、より優れた人工知能を生成することを目的としています。

Bittensor はビットコインからインスピレーションを得ており、ネイティブ通貨 TAO の供給量は 2,100 万で、半減サイクルは 4 年です (最初の半減期は 2025 年です)。 Bittensor は、Proof of Work を使用して正しい乱数を生成し、ブロック報酬を取得するのではなく、「Proof of Intelligence」に依存し、マイナーに推論リクエストの出力を生成できるモデルを実行するよう要求します。

インテリジェントなインセンティブ ネットワーク

Bittensor は当初、Mix of Experts (MoE) モデルを利用して出力を生成しました。推論リクエストが送信されると、一般的なモデルに依存する代わりに、MoE モデルは特定の入力タイプに対して最も正確なモデルに推論リクエストを渡します。これは、家を建てるときに、建設プロセスのさまざまな側面を処理するためにさまざまな専門家 (例: 建築家、エンジニア、塗装業者、建設労働者など) を雇うことにたとえることができます。 MoE はこれを機械学習モデルに適用し、入力に応じて異なるモデルの出力を活用しようとしています。 Bittensor の創設者である Ala Shaabana 氏は、それは「最良の答えを得るために、1 人の人間ではなく、賢い人々のグループと話す」ようなものだと説明しています。正しいルーティングの確保、正しいモデルへのメッセージの同期、およびモチベーションという課題のため、このアプローチはプロジェクトがより成熟するまで保留されています。

Bittensor ネットワークには、バリデーターとマイナーという 2 つの主な役割があります。バリデーターは、推論リクエストをマイナーに送信し、その出力をレビューし、応答の品質に基づいてランク付けする責任があります。ランキングの信頼性を確保するために、バリデーターには、そのランキングが他のバリデーターのランキングとどの程度一貫しているかに基づいて「vtrust」スコアが割り当てられます。バリデーターの vtrust スコアが高いほど、より多くの TAO を取得できます。これは、モデルのランキングについて合意に達するバリデーターが多ければ多いほど、個々の vtrust スコアが高くなるため、バリデーターが時間の経過とともにモデルのランキングについて合意に達することを奨励することを目的としています。

サーバーとも呼ばれるマイナーは、実際の機械学習モデルを実行するネットワーク参加者です。マイナーは、特定のクエリに対して最も正確な出力を提供するために互いに競争し、出力が正確であればあるほど、より多くの TAO 発行を受け取ることができます。マイナーはこれらの出力を任意の方法で生成できます。たとえば、将来のシナリオでは、Bittensor マイナーが事前に Gensyn でモデルをトレーニングし、それを使用して TAO を獲得することが完全に可能になります。

現在、ほとんどのやり取りはバリデーターとマイナーの間で直接行われます。バリデータはマイナーに入力を送信し、出力を要求します (モデルのトレーニングなど)。バリデーターがネットワーク内のマイナーにクエリを実行し、その応答を受け取ると、バリデーターをランク付けし、そのランキングをネットワークに送信します。

バリデーター (PoS に依存) とマイナー (PoW の形式である Proof of Model に依存) 間のこのやり取りは、Yuma コンセンサスと呼ばれます。これは、マイナーが TAO を獲得するために最適な出力を生成することを奨励し、バリデーターがマイナーの出力を正確にランク付けして、より高い vtrust スコアを獲得し、TAO 報酬を増やすことを奨励して、ネットワークのコンセンサス メカニズムを形成するように設計されています。

サブネットとアプリケーション

前述したように、Bittensor 上のインタラクションには主に、マイナーにリクエストを送信し、その出力を評価するバリデーターが含まれます。ただし、貢献するマイナーの品質が向上し、ネットワーク全体の人工知能が成長するにつれて、Bittensor は既存のスタックの上にアプリケーション層を作成し、開発者が Bittensor ネットワークにクエリを実行するアプリケーションを構築できるようにします。

2023 年 10 月、Bittensor は Revolution アップグレードにより、サブネットの導入というこの目標の達成に向けた重要なステップを完了しました。サブネットは、特定の動作を促進する Bittensor 上の独立したネットワークです。 Revolution は、サブネットの作成に興味がある人なら誰でもネットワークを公開します。立ち上げから数か月で、テキスト プロンプト、データ スクレイピング、イメージの生成と保存などのためのサブネットを含む 32 を超えるサブネットが立ち上げられました。サブネットが成熟し、製品の準備が整うと、サブネット作成者は、チームが特定のサブネットをクエリするアプリケーションを構築できるようにするアプリケーション統合も作成します。一部のアプリケーション (チャットボット、画像ジェネレーター、ツイート返信ボット、予測マーケット) は現在すでに存在していますが、Bittensor Foundation からの助成金を除けば、バリデーターがこれらのクエリを受け入れて転送するための正式なインセンティブはありません。

より明確な説明を提供するために、以下の画像は Bittensor 統合アプリケーションが実行されるものの例です。

サブネットは、ルート ネットワークによって評価されたパフォーマンスに基づいて TAO を受け取ります。ルート ネットワークはすべてのサブネットの最上位に位置し、基本的に特殊なタイプのサブネットとして機能し、64 の最大のサブネット バリデータによって共有ベースで管理されます。ルート ネットワーク バリデータは、パフォーマンスに基づいてサブネットをランク付けし、定期的に TAO をサブネットに割り当てます。このようにして、各サブネットはルート ネットワークのマイナーとして機能します。

ビテンソルの見通し

Bittensor は、複数のサブネットにわたるインテリジェンスの生成を奨励するためにプロトコル機能を拡張する中で、依然として成長痛を経験しています。マイナーは、モデルによって実行される高評価の推論の出力をわずかに変更して複数のバリエーションを送信するなど、より多くの TAO を獲得するためにネットワークを攻撃する新しい方法を考案し続けています。ネットワーク全体に影響を与えるガバナンス提案は、Opentensor Foundation の利害関係者のみで構成される Triumvirate によってのみ提出および実装できます (提案は実装前に Bittensor バリデータによる承認が必要であることに注意してください)。プロジェクトのトークンエコノミクスは、サブネット内での TAO 使用のインセンティブを向上させるために改善されています。このプロジェクトはそのユニークなアプローチでもすぐに人気を博し、最も人気のある人工知能 Web サイトである HuggingFace の CEO は、Bittensor はそのリソースを Web サイトに追加する必要があると述べました。

コア開発者によって公開された「Bittensor パラダイム」というタイトルの最近の記事で、チームは Bittensor が最終的には「測定対象にとらわれない」ものに進化するというビジョンを詳しく説明しました。理論的には、これにより Bittensor は TAO を利用して、あらゆるタイプの行動を奨励するサブネットを開発できるようになります。しかし、現実的な制約は依然としてかなりあります。主な制約は、これらのネットワークがこのような多様なプロセスを処理できるように拡張できること、および根底にあるインセンティブが集中化が提供できる以上の進歩を促進することを証明することです。

AI モデル用の分散コンピューティング スタックを構築する

上記のセクションでは、開発中のさまざまなタイプの分散型人工知能コンピューティング プロトコルのフレームワークを説明しました。これらはまだ開発と導入の初期段階にありますが、最終的には「DeFi Lego」コンセプトのような「AIビルディングブロック」の作成を促進する可能性のあるエコシステムの基盤を提供します。パーミッションレス ブロックチェーンの構成可能性により、各プロトコルを他のプロトコルの上に構築する可能性が開かれ、より包括的な分散型 AI エコシステムが提供されます。

たとえば、Akash、Gensyn、Bittensor が相互に対話して推論リクエストに応答する 1 つの方法を次に示します。

明確にしておきますが、これは将来何が起こるかの一例にすぎず、現在のエコシステム、既存のパートナー、または起こり得る結果を反映したものではありません。現在、相互運用性の制限および以下に説明するその他の考慮事項により、統合の可能性が大幅に制限されています。これに加えて、流動性の断片化と複数のトークンを使用する必要性がユーザーエクスペリエンスに悪影響を与える可能性があり、これはAkashとBittensorの創設者によって指摘されています。

その他の分散型製品

コンピューティングに加えて、仮想通貨の新たな人工知能エコシステムをサポートする分散型インフラストラクチャ サービスがいくつかあります。これらすべてをリストすることはこのレポートの範囲を超えていますが、興味深い代表的な例をいくつか示します。

Ocean: 分散型データ マーケットプレイス。ユーザーは自分のデータを表すデータ NFT を作成し、データ トークンを使用して購入できます。ユーザーは、AI 開発やトレーニング モデルに取り組むチームに必要なデータへのアクセスを提供しながら、データを収益化し、より大きな所有権を得ることができます。

Grass: 分散型帯域幅マーケットプレイス。ユーザーは余剰帯域幅を人工知能企業に販売し、インターネットからデータを収集するためにそれを使用できます。マーケットプレイスは Wynd Network 上に構築されており、個人が帯域幅を収益化できるだけでなく、帯域幅の購入者に、個々のユーザーがオンラインで見ているものについてより多様な視点を提供します (個人はインターネットを使用して、通常は特定の IP アドレスにアクセスするため) )。

HiveMapper: 自動車ドライバーから収集した情報を含む分散型マッピング製品を構築します。 HiveMapper は、人工知能を利用してユーザーの車のダッシュボード カメラで収集された画像を解釈し、強化人間学習フィードバック (RHLF) を通じて AI モデルの改善に協力したユーザーに報酬を与えます。

まとめると、これらは、AI モデルをサポートする分散型市場モデルを探索したり、これらのモデルの開発に必要な周囲のインフラストラクチャをサポートしたりするほぼ無限の機会を示しています。現在、これらのプロジェクトのほとんどは概念実証の段階にあり、必要な規模で包括的な AI サービスを提供できることを証明するには、さらなる研究開発が必要です。

見通し

分散型コンピューティング製品は、まだ開発の初期段階にあります。彼らは、最先端のコンピューティング能力を使用して、本番環境で最も強力な AI モデルをトレーニングし始めたばかりです。有意義な市場シェアを獲得するには、集中型の代替手段に対する実際の利点を実証する必要があります。より広範な採用の潜在的なきっかけとしては、次のようなものがあります。

GPUの需要と供給。 GPU の供給不足とコンピューティング需要の急速な高まりが相まって、GPU の争奪戦が勃発しています。 OpenAI は、GPU が限られているため、プラットフォームの使用を制限しています。 Akash や Gensyn などのプラットフォームは、ハイパフォーマンス コンピューティングを必要とするチームにコスト競争力のある代替手段を提供できます。今後 6 ~ 12 か月間は、分散型コンピューティング プロバイダーにとって、新規ユーザーを引き付けるまたとない機会となります。これらのユーザーは分散型ソリューションの検討を余儀なくされるからです。ますます効率化されるオープンソース モデル (Meta の LLaMA 2 など) と組み合わせることで、ユーザーは、コンピューティング リソースが大きなボトルネックとなっている効果的な微調整されたモデルの展開において、同じ障害に直面することがなくなりました。ただし、プラットフォームの存在自体では、コンピューティング リソースの十分な供給とそれに対応する消費者からの需要を保証することはできません。ハイエンド GPU の入手は依然として困難であり、コストが需要側の主な動機であるとは限りません。これらのプラットフォームは、固定ユーザーを蓄積するために、コスト、検閲への耐性、期間と回復力、使いやすさなどの理由で、分散型コンピューティングを使用する本当のメリットを実証することが求められます。これらの合意は迅速に進められる必要があります。 GPU インフラストラクチャへの投資と構築の速度は驚異的です。

監督。規制は引き続き、分散型コンピューティングの動きにとって大きな障害となっています。短期的には、明確な規制がないことは、プロバイダーとユーザーがこれらのサービスを使用する際に潜在的なリスクに直面することを意味します。プロバイダーが誤って計算を提供した場合、または購入者が認可された事業体から計算を購入した場合はどうなりますか?ユーザーは、集中型エンティティによる制御や監視が欠けている分散型プラットフォームの使用に消極的になる可能性があります。プロトコルは、プラットフォームに制御を組み込んだり、既知のコンピューティングプロバイダーのみにフィルターを提供したり(つまり、KYC 情報を提供したり)、これらの懸念を軽減しようと試みてきましたが、導入を促進するには、コンプライアンスを確保しながらプライバシーを保護するためのより堅牢なアプローチが必要です。短期的には、これらの問題に対処するためにプロトコルの使用を制限する、KYC および規制に準拠したプラットフォームが出現する可能性があります。

レビュー。規制は双方向に機能し、分散型コンピューティングプロバイダーは人工知能の使用を制限する措置から恩恵を受ける可能性があります。大統領令に加え、OpenAI創設者のサム・アルトマン氏は議会で証言し、人工知能開発のライセンスを発行する規制当局の必要性を強調した。 AI規制を巡る議論は始まったばかりだが、AIの使用を制限したり検閲しようとする試みは、こうした障壁のない分散型プラットフォームの導入を加速させる可能性がある。昨年 11 月の OpenAI のリーダー交代は、最も強力な既存の AI モデルに対する意思決定権を少数の人々に与えることのリスクをさらに証明しました。さらに、すべての AI モデルは、意図的であるかどうかにかかわらず、作成者のバイアスを必然的に反映します。これらのバイアスを排除する 1 つの方法は、モデルを微調整やトレーニングに対して可能な限りオープンにし、誰でも、どこでも、さまざまなバイアスのあるモデルを使用できるようにすることです。

データのプライバシー。ユーザーにデータの自律性を提供する外部データおよびプライバシー ソリューションと統合すると、分散型コンピューティングは代替手段よりも魅力的なものになる可能性があります。サムスンは、エンジニアがチップ設計を支援するために ChatGPT を使用し、機密情報が ChatGPT に漏洩したことに気づき、この問題に悩まされました。 Phala Network と iExec は、ユーザー データを保護するために SGX セキュリティ分離ゾーンをユーザーに提供すると主張しており、プライバシーを確保する分散コンピューティングをさらに解放するための完全準同型暗号化の研究を行っています。 AI が私たちの生活にさらに統合されるにつれて、ユーザーはプライバシー保護機能を備えたアプリケーション上でモデルを実行できることをより重視するようになります。また、ユーザーは、あるモデルから別のモデルにデータをシームレスに移動できるように、データ コンポーザビリティを実装する機能も要求します。

ユーザーエクスペリエンス(UX)。ユーザー エクスペリエンスは、あらゆるタイプの暗号アプリケーションやインフラストラクチャを広く採用する上で依然として大きな障壁となっています。分散型コンピューティング ソリューションも例外ではなく、場合によっては、開発者が暗号化と人工知能を理解する必要があるため、これがさらに悪化します。改善が必要な領域は、オンボーディングやブロックチェーンとの対話の抽象化から、現在の市場リーダーと同じ高品質の成果物の提供まで多岐にわたります。実行中の分散コンピューティング プロトコルの多くは安価なソリューションを提供しますが、定期的に使用するのが難しいため、これは明らかです。

スマート コントラクトとゼロ知識機械学習 (zkML)

スマート コントラクトは、ブロックチェーン エコシステムの中核の 1 つです。特定の条件下では、自動化され、信頼できるサードパーティの必要性が軽減または排除され、DeFi で見られるような複雑な分散型アプリケーションの作成が可能になります。ただし、現時点では、スマート コントラクトは更新する必要がある事前設定されたパラメーターに基づいて実行されるため、機能がまだ制限されています。

たとえば、融資プロトコルのスマート コントラクトは、特定の融資対価値比率に基づいてポジションがいつ清算されるかを規制します。リスクが絶えず変化する動的な環境では、リスク許容度の変化を考慮してスマートコントラクトを常に更新する必要があり、分散プロセスで管理される契約に課題が生じます。たとえば、分散型ガバナンス プロセスに依存する DAO は、システミック リスクにタイムリーに対応できない可能性があります。

人工知能 (機械学習モデルなど) を統合するスマート コントラクトは、全体的なユーザー エクスペリエンスを向上させながら、機能、セキュリティ、効率を強化する可能な方法の 1 つです。ただし、これらのスマート コントラクトをサポートするモデルが攻撃されたり、ロングテール シナリオを考慮したりできないことを保証する方法がないため、これらの統合は追加のリスクももたらします (データ入力が不足しているため、モデルのトレーニングが難しいことで有名です)。

ゼロ知識機械学習 (zkML)

機械学習には複雑なモデルを実行するために大量のコンピューティング リソースが必要ですが、コストが高いため、AI モデルをスマート コントラクト内で直接実行することは不可能です。たとえば、DeFi プロトコルは収益最適化モデルの機能をユーザーに提供しますが、チェーン上でモデルを実行しようとすると、高額なガス料金を支払わなければなりません。解決策の 1 つは、基盤となるブロックチェーンの計算能力を高めることです。ただし、これによりチェーンの検証ノードの負担も増加し、分散型の特性が弱まる可能性があります。その結果、いくつかのプロジェクトは、zkML を使用して、集中的なオンチェーン計算を必要とせずに、パーミッションレスでトラストレスな方法で出力を検証する方法を模索しています。

zkML の有用性を示す一般的な例は、ユーザーがモデルを通じてデータを実行し、相手が実際に正しいモデルを実行していることを確認するために他の人が必要な場合です。おそらく、開発者はモデルのトレーニングに分散コンピューティング プロバイダーを使用しており、プロバイダーが安価なモデルを使用してコストを節約しようとしているのに、出力がほとんど目立たないことを懸念しています。 zkML を使用すると、コンピューティング プロバイダーはモデルを通じてデータを実行し、モデルの出力が特定の入力に対して正しいことをオンチェーンで検証できる証明を生成できます。この場合、モデルプロバイダーには、出力を生成する基礎となる重みを明らかにせずにモデルを提供できるという追加の利点があります。

逆のことも起こり得ます。ユーザーが自分のデータを使用するモデルを実行したいが、プライバシー上の懸念 (健康診断やビジネス上の機密情報など) を理由に、モデルを提供するプロジェクトに自分のデータにアクセスさせたくない場合、ユーザーはそのモデルを次の場所で実行できます。データ モデルを共有せずに検証し、証拠を提供しながら正しいモデルを実行したことを検証します。これらの可能性により、限られた計算上の制約を解決することで、人工知能とスマート コントラクト機能を統合するための設計スペースが大幅に拡大します。

インフラストラクチャとツール

zkML 分野の初期の状態を考慮すると、開発は主に、チームがモデルと出力をオンチェーンで検証できるプルーフに変換するために必要なインフラストラクチャとツールを構築することに焦点を当てています。これらの製品は、開発におけるゼロ知識の側面を可能な限り抽象化します。

EZKL と Giza の 2 つのプロジェクトは、機械学習モデルの実行の検証可能な証拠を提供することにより、これらのツールに基づいて構築されています。どちらも、チームが機械学習モデルを構築し、信頼することなく結果をオンチェーンで検証できる方法でモデルが実行できるようにするのに役立ちます。どちらのプロジェクトも Open Neural Network Exchange (ONNX) を使用して、TensorFlow や Pytorch などの共通言語で記述された機械学習モデルを標準形式に変換します。次に、実行時にこれらのモデルのバージョンを出力し、zk 証明も生成します。 EZKL はオープン ソースで zk-SNARKS を生成しますが、Giza はクローズド ソースで zk-STARKS を生成します。これら 2 つのプロジェクトは現在 EVM とのみ互換性があります。

過去数か月間、EZKL は主にコストの削減、セキュリティの向上、プルーフ生成の加速に重点を置いて、zkML ソリューションの強化において大きな進歩を遂げてきました。たとえば、2023 年 11 月に、EZKL は新しいオープンソース GPU ライブラリを統合し、全体的な証明時間を 35% 短縮しました。また、1 月には、EZKL を使用した証明のためのソフトウェア ソリューションである Lilith を発表しました。このシステムは、高性能コンピューティング クラスターを統合し、同時実行を調整します。仕事。 Giza がユニークなのは、検証可能な機械学習モデルを作成するためのツールを提供することに加えて、Hugging Face に相当する Web3 を実装し、zkML コラボレーションとモデル共有のためのユーザー マーケットプレイスをオープンし、最終的には分散型コンピューティング製品を統合することを計画しているという点です。 EZKL は 1 月に、EZKL、Giza、RiscZero (後述) のパフォーマンスを比較したベンチマーク評価を発表しました。 EZKL は証明時間とメモリ使用量が高速になります。

Modulus Labs は、人工知能モデルに合わせた新しい zk プルーフ技術も開発しています。 Modulus は、「The Cost of Intelligence」(チェーン上で AI モデルを実行するコストが非常に高いことを暗示しています)と呼ばれる論文を発表し、当時の既存の zk-proofs システムをベンチマークして、改良された AI モデル zk-proofs の機能とボトルネックを特定しました。 2023 年 1 月に発表されたこの論文は、既存のソリューションは大規模な AI アプリケーションを実現するにはコストと効率が高すぎることを示しています。 Modulus は、初期の研究に基づいて、プロジェクトがモデルを大規模にシステムに統合することを経済的に実現可能にすることを目的として、AI モデルのコストと証明時間を削減するために特別に構築されたプロフェッショナルなゼロ知識証明者である Remainder を 11 月に発売しました。 。彼らの成果はクローズドソースであるため、上記のソリューションに対してベンチマークを行うことはできませんが、暗号化と人工知能に関する Vitalik のブログ投稿で最近言及されました。

ツールとインフラストラクチャの開発は、検証可能なオフチェーン計算のためにチームが zk 回路を展開するために必要な摩擦を大幅に軽減するため、zkML 分野の将来の成長にとって重要です。機械学習の分野で働く非暗号ネイティブ開発者がモデルをオンチェーンに導入できる安全なインターフェイスを作成することで、真に斬新なユースケースを備えたアプリケーションの実験を増やすことが可能になります。これらのツールは、zkML の広範な導入に対する大きな障壁である、ゼロ知識、機械学習、暗号化の交差点に関する知識と関心を持つ開発者の不足にも対処します。

コプロセッサ

「コプロセッサ」と呼ばれる開発中の他のソリューションには、RiscZero、Axiom、Ritual などがあります。 「コプロセッサ」という用語はほとんどが意味論的なものであり、これらのネットワークは、オフチェーン計算のオンチェーン検証を含む、さまざまな役割を果たします。 EZKL、Giza、Modulus と同様に、彼らの目標は、ゼロ知識証明生成プロセスを完全に抽象化し、それによって本質的にオフチェーンでプログラムを実行し、オンチェーン検証用の証明を生成できるゼロ知識仮想マシンを作成することです。 RiscZero と Axiom はより汎用的なコプロセッサであるため、単純な AI モデルを処理できますが、Ritual は AI モデルでの使用に特化して構築されています。

Infernet は Ritual の最初のインスタンスであり、開発者が推論リクエストをネットワークに送信し、オプションで戻り時に出力と証明を受信できるようにする Infernet SDK が含まれています。インファーネット ノードはこれらのリクエストを受信し、オフチェーンで計算を処理し、出力を返します。たとえば、DAO は、すべての新しいガバナンス提案が提出前に特定の前提条件を満たしていることを確認するプロセスを作成できます。新しい提案が提出されるたびに、ガバナンス コントラクトは Infernet を介して推論リクエストをトリガーし、DAO 固有のガバナンスでトレーニングされた AI モデルを呼び出します。モデルは提案をレビューして、必要な条件がすべて提出されていることを確認し、提案の提出を承認または拒否する出力と証明書を返します。

来年にかけて、Ritual チームは、Ritual スーパーチェーンと呼ばれるインフラストラクチャ層を構成する追加機能を展開する予定です。前に説明した項目の多くは、サービス プロバイダーとして Ritual にプラグインできます。現在、Ritual チームはプルーフ生成のために EZKL と統合しており、間もなく他の主要プロバイダーの機能を追加する可能性があります。 Ritual 上の Infernet ノードは、Akash または io.net GPU を使用し、Bittensor サブネットでトレーニングされたモデルをクエリすることもできます。彼らの最終目標は、あらゆるネットワーク上のあらゆるジョブで機械学習やその他の AI 関連タスクを提供できるオープン AI インフラストラクチャの頼りになるプロバイダーになることです。

応用

zkML は、ブロックチェーンと人工知能の間の矛盾を調和させるのに役立ちます。前者は本質的にリソースに制約があり、後者は大量のコンピューティングとデータを必要とします。 Giza の創設者の 1 人は次のように述べています。「ユースケースは非常に豊富です...イーサリアムの初期にスマート コントラクトにどのようなユース ケースがあるのかを尋ねるようなものです...私たちはスマート コントラクトのユース ケースを拡大していますただし、前述したように、今日の開発は主にツールとインフラストラクチャのレベルに焦点を当てていることが強調されています。このアプリケーションはまだ探索段階にあり、チームの課題は、zkML を使用してモデルを実装する価値が、その複雑さとコストを上回ることを実証することです。

現在のアプリケーションには次のようなものがあります。

DeFi。 zkMLは、スマートコントラクトの機能を強化することでDeFiを拡張します。 DeFi プロトコルは、機械学習モデル用の検証可能かつ不変の大量のデータを提供し、これを使用して利回りや取引戦略、リスク分析、UX などを生成できます。たとえば、Giza は Yearn Finance と提携して、Yarn の新しい v3 ボールト用の概念実証自動リスク評価エンジンを構築しました。 Modulus Labs は Lyra Finance と提携して機械学習を AMM に組み込み、Ion Protocol と提携して検証リスク モデルを実現し、Upshot による AI ベースの NFT 価格データ フィードの検証を支援しました。 NOYA (EZKL を利用する) や Mozaic などのプロトコルは独自のオフチェーン モデルへのアクセスを提供し、ユーザーが自動化された APY ガン プールを利用できると同時に、オンチェーンでデータ入力と証明を検証できます。 Spectral Finance は、Compound または Aave の借り手の債務不履行の可能性を予測するためのオンチェーン信用スコアリング エンジンを構築しています。これらのいわゆる「De-Ai-Fi」製品は、zkML のおかげで、今後数年間でさらに一般的になることが予想されます。

ゲーム。ブロックチェーンはゲームを破壊し、強化する機が熟していると長い間考えられてきました。 zkML により、オンチェーンでのゲームに人工知能を使用できるようになります。 Modulus Labs は、単純なオンチェーン ゲームの概念実証を実装しました。 Leela vs the World は、ユーザーが AI チェス モデルと対戦するゲーム理論のチェス ゲームです。zkML は、Leela のすべてのステップがゲームで使用されるモデルに基づいて実行されていることを検証します。同様に、チームは EZKL フレームワークを使用して、簡単な歌唱コンテストとオンチェーン三目並べを構築しました。カートリッジは、Giza を活用して、チームが完全にオンチェーンでゲームを展開できるようにしており、最近では、車が障害物を回避できるようにするより良いモデルを作成するためにユーザーが競うシンプルな AI ドライビング ゲームをリリースしました。シンプルではありますが、これらの概念実証は、スーパー マリオに似たゲームである AI アリーナでの高度な NPC キャラクターとのゲーム経済的相互作用など、より複雑なオンチェーン検証の将来の実装を示しています。プレイヤーは自分の戦士を訓練し、AI として展開します。戦うためのモデル。

アイデンティティ、トレーサビリティ、プライバシー。暗号化は、信頼性を検証し、増え続ける AI によって生成/操作されたコンテンツやディープフェイクに対抗する手段としてすでに使用されています。 zkML はこれらの取り組みを前進させることができます。 WorldCoin は、ユーザーが自分の虹彩をスキャンして一意の ID を生成する必要がある人格証明ソリューションです。将来的には、生体認証情報をローカルで検証するために必要なモデルを使用して、暗号化を使用して生体認証 ID を個人のデバイスに自己保存できるようになる可能性があります。ユーザーは身元を明らかにすることなく生体認証情報の証拠を提供できるため、プライバシーを確保しながらシビル攻撃に対抗できます。これは、プライバシーを必要とする他の推論にも適用できます。たとえば、モデルを使用して医療データ/画像を分析して病気を検出したり、個人の身元を確認したり、出会い系アプリでマッチング アルゴリズムを開発したり、財務情報の検証が必要な保険や融資機関などに適用できます。

見通し

zkML はまだ実験段階にあり、ほとんどのプロジェクトはインフラストラクチャのプロトタイプの構築と概念実証に重点を置いています。現在の課題には、計算コスト、メモリの制限、モデルの複雑さ、限られたツールとインフラストラクチャ、開発人材が含まれます。つまり、zkML が消費者向け製品に必要な規模を達成するには、やるべきことがまだたくさんあります。

ただし、この分野が成熟し、これらの制限が解決されるにつれて、zkML は AI と暗号化統合の重要なコンポーネントになるでしょう。 zkML はその中核として、オンチェーンで実行する計算と同じまたはほぼ同じセキュリティ保証を維持しながら、あらゆる規模でオフチェーンの計算をオンチェーンに持ち込む機能を約束します。ただし、このビジョンが実現するまで、このテクノロジーの早期導入者は、zkML のプライバシーとセキュリティを代替手段の効率と比較検討し続ける必要があります。

人工知能エージェント

人工知能と暗号通貨の最も興味深い統合の 1 つは、人工知能エージェントを使用した継続的な実験です。エージェントは、AI モデルを使用してタスクを受信、解釈、実行できる自律型ロボットです。エージェントには、常に利用可能で好みに応じて最適化されるパーソナルアシスタントを配置することから、ユーザーのリスク選好に応じて投資ポートフォリオを管理および調整する金融エージェントを雇うことまで、さまざまなものが考えられます。

暗号通貨はパーミッションレスでトラストレスな支払いインフラストラクチャを提供するため、プロキシと暗号通貨はうまく連携します。トレーニングが完了すると、エージェントはウォレットを取得できるようになり、自分でスマート コントラクトを取引できるようになります。たとえば、今日では単純なエージェントがインターネット上で情報を検索し、モデルに基づいて予測市場で取引することができます。

代理店プロバイダー

Morpheus は、2024 年に Ethereum と Arbitrum 上で開始された最新のオープンソース プロキシ プロジェクトの 1 つです。そのホワイトペーパーは 2023 年 9 月に匿名で公開され、コミュニティを形成および構築するための基礎を提供しました (Erik Vorhees のような著名な人物も含まれます)。ホワイトペーパーには、ダウンロード可能なスマート エージェント プロトコルが含まれています。これは、ローカルで実行でき、ユーザーのウォレットによって管理され、スマート コントラクトと対話できるオープン ソース LLM です。スマート コントラクトのランキングを使用して、エージェントが処理されたトランザクション数などの基準に基づいてどのスマート コントラクトを安全に操作できるかを判断できるようにします。

ホワイトペーパーでは、スマート エージェント プロトコルの実装に必要なインセンティブ構造やインフラストラクチャなど、Morpheus ネットワークを構築するためのフレームワークも提供します。これには、エージェントと対話するフロントエンドのインターフェイスを構築するよう貢献者を奨励すること、エージェントにプラグインして相互に対話できるアプリケーションを開発者に構築するための API を提供すること、ユーザーが次の機能を使用できるようにクラウド ソリューションを提供することなどが含まれます。エッジデバイス上でエージェントを実行するには、コンピューティングとストレージが必要です。プロジェクトへの最初の資金調達は 2024 年第 2 四半期初めに開始され、その時点で完全なプロトコルが開始される予定です。

分散型自律インフラストラクチャ ネットワーク (DAIN) は、Solana 上でエージェント間の経済を構築する新しいエージェント インフラストラクチャ プロトコルです。 DAIN の目標は、さまざまな企業のエージェントが共通の API を介して相互にシームレスに対話できるようにすることです。これにより、Web2 および Web3 製品と対話できるエージェントの実装に重点を置き、AI エージェントの設計スペースを大幅に広げることができます。 DAINは1月に、ユーザーが自分のマルチ署名に「代理署名者」を追加できるようにするため、Asset Shieldとの初の提携を発表した。代理署名者は、ユーザーが設定したルールに従ってトランザクションを解釈し、承認/拒否できる。

Fetch.AI は、最初に導入された人工知能エージェント プロトコルの 1 つであり、FET トークンと Fetch.AI ウォレットを使用してオンチェーンでエージェントを構築、導入、使用するためのエコシステムを開発しました。このプロトコルは、プロキシと対話してコマンドを発行するためのウォレット内機能など、プロキシを操作するための包括的なツールとアプリケーションのセットを提供します。

Fetch チームの元メンバーによって設立された Autonolas は、分散型人工知能エージェントを作成および使用するためのオープン マーケットプレイスです。 Autonolas は、Polygon、Ethereum、Gnosis Chain、Solana などの複数のチェーンに接続できる、オフチェーンでホストされる AI エージェントを構築するためのツール セットも開発者に提供します。同社は現在、予測市場や DAO ガバナンス向けの製品など、アクティブなプロキシの概念実証製品を多数保有しています。

SingularityNet は、AI エージェントの分散型マーケットプレイスを構築しています。そこでは人々が特定の領域に焦点を当てた AI エージェントを展開でき、これらのエージェントを他の人やエージェントに雇って複雑なタスクを実行させることができます。 AlteredStateMachine などの他のプロジェクトは、AI エージェントと NFT の統合を構築しています。ユーザーは、さまざまなタスクに対して利点と欠点を与えるランダムな特性を備えた NFT を作成します。これらのエージェントは、特定の特性を強化するようにトレーニングされ、ゲーム、DeFi、または仮想アシスタントとして使用され、他のユーザーとの取引を行うことができます。

これらのプロジェクトは集合的に、タスクを実行するだけでなく汎用人工知能の構築にも役立つように連携するエージェントの将来のエコシステムを構想しています。真に洗練されたエージェントは、あらゆるユーザー タスクを自律的に実行できるようになります。たとえば、完全自律型エージェントは、エージェントが外部 API (旅行予約 Web サイトなど) を使用するためにその API を統合していることを確認するのではなく、API を統合するために別のエージェントを雇う方法を見つけ出すことができます。タスクを実行します。ユーザーの観点から見ると、エージェントがタスクを実行できるかどうかを独自に判断できるため、エージェントがタスクを実行できるかどうかを確認する必要はありません。

ビットコインとAIエージェント

2023 年 7 月、Lightning Labs は、LangChain Bitcoin Suite と呼ばれる、Lightning ネットワーク上でプロキシを使用するための概念実証ソリューションを開始しました。この製品は、Web 2 の世界で増大する問題、つまり Web アプリケーションと高価な API サービスのゲート (アクセスの制限) を解決することを目的としているため、特に興味深いです。

LangChain は、エージェントがビットコインを購入、販売、保持できるだけでなく、API キーのクエリやマイクロペイメントの送信を可能にする一連のツールを開発者に提供することで、この問題を解決します。従来の支払いチャネルでは、手数料の問題により少額のマイクロペイメントは基本的に実現できませんが、ライトニング ネットワークでは、エージェントは毎日無制限にマイクロペイメントを送信し、最小限の手数料のみを支払うことができます。 LangChain の L 402 支払い測定 API フレームワークと組み合わせると、企業は単一のコスト基準を設定するのではなく、使用量の増減に基づいて API の使用料金を調整できます。

オンチェーンのアクティビティがエージェント間の対話によって支配される将来では、法外なコストがかからない方法でエージェントが相互に対話できるようにするために、上記のことが必要になります。これは、エージェントを許可不要でコスト効率の高い支払いレールでどのように使用できるかを示す初期の例であり、新しい市場と経済的相互作用の可能性を切り開きます。

見通し

代理店スペースはまだ初期段階にあります。

このプロジェクトは、そのインフラストラクチャを使用して単純なタスクを処理できる機能エージェントの展開を開始したところです。通常、経験豊富な開発者とユーザーのみが利用できるものです。

ただし、AI エージェントが時間の経過とともに暗号空間に与える最大の影響の 1 つは、あらゆる業種にわたるユーザー エクスペリエンスを向上させることです。トランザクションはクリックベースからテキストベースに移行し始め、ユーザーは大規模言語モデル(LLM)を通じてオンチェーンエージェントと対話できるようになります。 Dawn Wallet のような、ユーザーがオンチェーンで対話できるチャットボット ウォレットを立ち上げたチームがすでに存在します。

さらに、金融レールは規制された銀行機関に依存しているため、プロキシが Web 2.0 でどのように機能するかは不明であり、金融機関は 24 時間年中無休で運営できず、シームレスな国境を越えた取引を可能にすることができません。リン・アルデン氏が強調しているように、仮想通貨チャネルは、払い戻しがなく少額の取引を処理できるため、クレジット カードと比較して特に魅力的です。ただし、エージェントがより一般的になる場合、既存の決済プロバイダーやアプリケーションは、既存の金融チャネルでの運用を可能にするために必要なインフラストラクチャの実装に迅速に移行し、暗号化を使用する利点の一部が軽減される可能性があります。

現在、エージェントは、特定の入力が特定の出力を保証する決定論的な暗号通貨トランザクションに限定されている可能性があります。これらのエージェントの機能を活用して複雑なタスクを実行する方法のモデルや、エージェントが実行できるタスクの範囲を拡張するツールには、さらなる開発が必要です。仮想通貨プロキシが新たなオンチェーン仮想通貨のユースケースを超えて有用になるためには、決済形式としての仮想通貨のより広範な統合と受け入れ、そして規制の明確化が必要となります。ただし、これらのコンポーネントが進化するにつれて、エージェントは、前述の分散コンピューティングおよび zkML ソリューションの最大の消費者の 1 つとなり、自律的かつ非決定的な方法であらゆるタスクを受け取り、解決することになります。

結論は

人工知能は、Web2 ですでに見られたのと同じ革新を暗号通貨にもたらし、インフラストラクチャ開発からユーザー エクスペリエンスや使いやすさに至るまで、あらゆるものを強化します。しかし、このプロジェクトはまだ初期段階にあり、短期的には暗号通貨と AI の統合はオフチェーン統合によって支配されることになるでしょう。

Copilot のような製品は「開発効率を 10 倍向上」させ、Microsoft などの大手企業と提携して、レイヤー 1 および DeFi アプリケーションはすでに AI 支援開発プラットフォームを立ち上げています。 Cub 3.ai や Test Machine などの企業は、オンチェーンのセキュリティを強化するために、スマート コントラクトの監査とリアルタイムの脅威監視のための人工知能を開発しています。 LLM チャットボットは、ユーザーの使いやすさとユーザー エクスペリエンスを向上させるために、オンチェーン データ、プロトコル ファイル、アプリケーションを使用してトレーニングされています。

より高度な統合では、暗号通貨の基盤となるテクノロジーを真に活用するために、AI ソリューションをオンチェーンに実装することが技術的に実現可能であり、大規模に経済的に実現可能であることを証明することが課題となります。分散型コンピューティング、zkML、AI エージェントの開発はいずれも有望な分野を示しており、暗号通貨と AI が深く絡み合う未来への布石となっています。