A16z: 生成 AI が直面する機会と課題

出典: アルファウサギの研究ノート

出典: アルファウサギの研究ノート

原文翻訳:アルファ・ラビット

A16Z は最近、自分たちの考えについて語る興味深い記事を投稿しました。生成的な AI 価値の獲得たとえば、生成 AI の商用化における現在の問題点は何ですか?最大の価値を獲得できるのはどこでしょうか?内容の一部に翻訳後に著者による注釈を付けました。

この記事には 2 つの主要な部分があります: 最初の部分では、生成 AI の現在の軌道全体に関する A16Z の観察と、どのような問題が存在するかが含まれています; 2 番目の部分では、間違いなく世界の基盤となる問題に加えて、どれが最大の価値を獲得できるかを説明します。施設の(注意: これらのほとんどは A16Z ポートフォリオです。客観的かつ合理的な態度で読んでください。この記事はプロジェクトへの投資アドバイスや推奨を構成するものではありません)

最初のレベルのタイトル

生成AIとは何ですか?

最初のレベルのタイトル

パート I: 観察と予測

人工知能アプリケーションの規模は急速に拡大していますが、維持するのはそれほど簡単ではなく、誰もが商業規模を確立できるわけではありません。

生成 AI テクノロジーの初期段階が明らかになりました。

たとえば、何百もの初期の AI スタートアップ企業が、基礎モデルの開発と AI ネイティブのアプリケーション、インフラストラクチャ、ツールの構築を開始するために市場に殺到しています。

もちろん、ホットなテクノロジートレンドもたくさんあるでしょうし、過度に誇大宣伝されるケースもあるでしょう。しかし、生成人工知能のブームにより、多くの企業が実質収益を生み出しています。

たとえば、Stable Diffusion や ChatGPT などのモデルはユーザー増加の歴史的記録を打ち立て、一部のアプリは発売から 1 年も経たないうちに年間収益が 1 億ドルに達し、一部のタスクにおける AI モデルのパフォーマンスは人間のパフォーマンスより桁違いに高くなっています。

テクノロジーのパラダイムシフトが起きていることが分かりました。しかし、研究する必要がある重要な問題は、市場全体のどこで価値が生み出されるのかということです。

過去 1 年間、私たちは生成 AI スタートアップの創業者や大企業の AI 専門家数十人と話をしてきました。インフラストラクチャは生成 AI スタック全体を通じて最大の売上高と収益を獲得できるため、これまでのところ、インフラストラクチャ プロバイダーがこの市場で最大の勝者になる可能性が高いと考えられます。

アプリケーション開発に注力している企業の収益成長は非常に速いですが、これらの企業はユーザー維持、製品の差別化、粗利益率の点で弱点を抱えていることがよくあります。しかし、ほとんどのモデルサプライヤーはまだ大規模な商品化能力を習得していません。

より正確に言うと、生成人工知能モデルをトレーニングし、このテクノロジーを新しいアプリケーションに適用できるなど、最大の価値を生み出すことができる企業は、まだ業界の価値の大部分を完全には獲得していません。したがって、業界の背後にある動向を予測するのはそれほど簡単ではありません。

ただし、業界全体のどの部分が真に差別化でき、防御可能であるかを理解する方法を見つけることが重要です。この部分は、市場全体の構造 (つまり、企業の水平的および垂直的発展) や長期的な価値の推進力に影響を与える可能性があるためです。 (利益率やユーザー維持など)は大きな影響を及ぼします。

しかしこれまでのところ、既存企業の伝統的なビジネス堀以外に、(生成型 AI の)スタック上で構造的な防御可能性を見つけることは困難でした。

副題

テクノロジースタック: インフラストラクチャ、AI モデル、アプリケーション

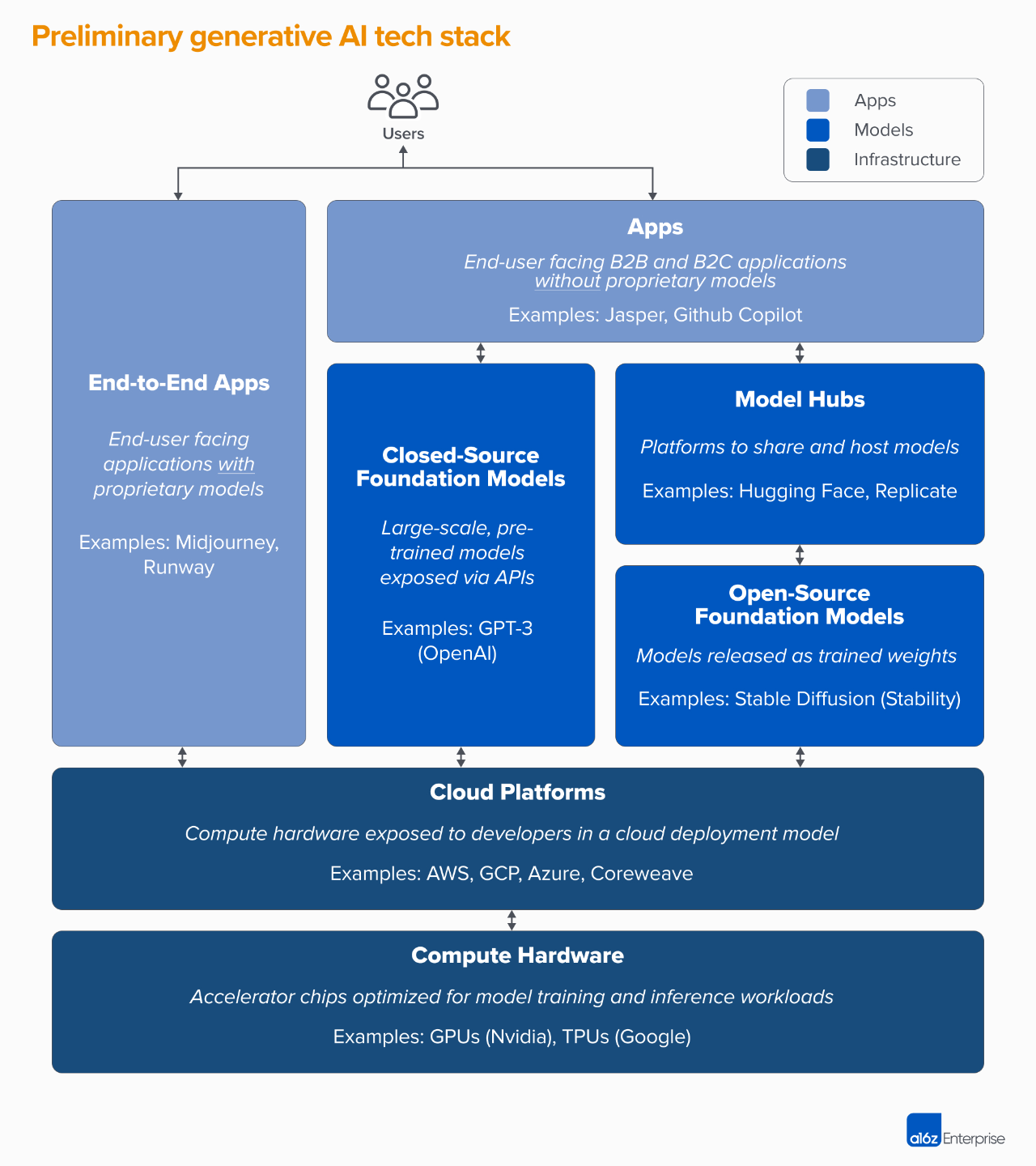

生成型人工知能の軌道と市場がどのように形成されているかを理解するには、まず業界全体の現在のスタックを定義する必要があります。

生成 AI スタック全体は 3 つの層に分割できます。

1. 通常は独自のモデル パイプラインを実行して、生成 AI モデルをユーザー向けの製品アプリケーションと統合します ("エンドツーエンドのアプリケーション")、またはサードパーティ API に依存する

(Alpha Rabbit の研究メモへの注: ここで話しているモデル パイプラインとは、あるモデルの出力を次のモデルの入力として指します)

2. AI 製品を強化するモデル。独自の API またはオープンソース チェックポイントとして利用可能 (ホスト型ソリューションが必要)

(注: このセクションでは、モデル全体と事前トレーニング済みモデル (チェックポイントとも呼ばれます) の構築方法が公開されているか、モデル全体と事前トレーニング済みモデルの構築方法が秘密にされている必要があるかのどちらかであると述べています。公開されているインターフェース API は 1 つだけですが、前者の場合、トレーニング/微調整/推論を自分で実行する必要があるため、どのような環境でどのようなハードウェアで実行できるかを知る必要があるため、誰かが必要とします。モデル実行環境を処理するためのホスティング プラットフォームを提供する)

3. 生成 AI モデルのトレーニングと推論ワークロードを実行するインフラストラクチャ プロバイダー (クラウド プラットフォームやハードウェア メーカーなど)

なお、ここでお話しするのは市場全体の生態マップではなく、市場を分析するためのフレームワークであり、各カテゴリーの有名メーカーの例をいくつか挙げていますが、すべてを網羅しているわけではありません。この分野はまだ本格的な標準化に達していないため、強力な AIGC アプリケーションでは MLops ツールや LLLMops ツールについては詳しく説明されていませんが、機会があれば引き続き説明する予定です。

生成 AI アプリケーションの第 1 波は拡大し始めていますが、維持して差別化するのは簡単ではありません

以前のテクノロジーサイクルでは、独立した大企業を構築するには最終顧客が必要であり、最終顧客には個人消費者や B2B 購入者が含まれる、というのが従来の考え方でした。

この伝統的な観点のため、生成人工知能における最大のチャンスはエンドユーザー指向のアプリケーションを作成できる企業にあると誰もが考えがちです。

しかしこれまでのところ、必ずしもそうではありません。

生成 AI アプリケーションの成長は、主に画像生成、コピーライティング、コーディングなどの非常に斬新なユースケースによって促進され、驚異的であり、これら 3 つの製品カテゴリの年間収益は 1 億米ドルを超えています。

しかし、成長だけでは持続的なソフトウェア会社を構築するのに十分ではありません。重要なのは、この成長が収益性を伴うものであること、つまり、ユーザーと顧客がサインアップすると利益を生み出すことができ (高い粗利益)、この利益が持続可能である必要があるということです。長期的には持続可能(高い定着率)。

企業間に強力な技術的差別化が存在しない場合、B2B アプリケーションと B2C アプリケーションは、ネットワーク効果、データの利点、またはますます複雑になるワークフローの構築によってのみ成功できます。

ただし、生成人工知能の分野では、上記の仮定は当てはまらない可能性があります。私たちが調査した生成型人工知能 APP を開発する新興企業の中で、粗利率は大きく異なり、少数の企業では 90% に達することもありますが、ほとんどの企業の粗利率は 50 ~ 60% 程度です。これが主に影響を受けています。モデルのコストによって。

現在のトップオブファネル(Top-of-Funnel)の成長は見られますが、ただし、現在の顧客獲得戦略を維持できるかどうかは不透明というのは、有料獲得の効率と維持率が低下し始めるのを私はたくさん見てきたからです。

現在市場に出ているアプリケーションの多くは差別化に欠けており、これらのアプリケーションは主に同様の基盤となる人工知能モデルに依存しており、明らかに排他的なネットワーク効果を持ち、他の競合他社が複製するのが難しいキラーアプリケーションやデータが見つかっていないためです。

副題

将来に目を向けると、生成 AI アプリケーションはどのような問題に直面するのでしょうか?

垂直統合では ("モデル + アプリケーション")側面

人工知能モデルが消費者サービスとして使用される場合、アプリケーション開発者は小規模なチーム モデルを迅速に反復し、テクノロジーの進歩に応じてモデルのサプライヤーを徐々に置き換えることができます。しかし、他の開発者はこれに同意せず、製品がモデルであり、防御力を高める唯一の方法はスクラッチからのトレーニングであると信じており、これは独自の製品データを継続的に再トレーニングすることを指します。しかし、これにはより多くの資本が必要であり、安定した製品チームが犠牲になります。

機能とアプリを構築する

ジェネレーティブ AI 製品には、デスクトップ アプリ、モバイル アプリ、Figma/Photoshop プラグイン、Chrome 拡張機能、さらには Discord ボットなど、さまざまな形があります。ユーザー インターフェイスがシンプルになるため、ユーザーがすでに使用していて習慣がある人工知能製品を統合するのが簡単です。しかし、これらの企業のうち、どの企業が独立した企業になるのでしょうか? AI巨人のマイクロソフトとグーグルに吸収されるのはどっちだろうか?

Gartner が発表したハイパー サイクルと一致しますか?

最初のレベルのタイトル

パート II: 生成人工知能の大規模な商用実装

最初の部分では、生成 AI の現在のスタックと、それが直面する問題のいくつかについて話しました。 2 番目の部分は次のように続きます。

生成型人工知能の大規模商用実装について

そして、Winner Takes All が最も価値を発揮するのはどこでしょうか?

上記の他にご質問がありますか?

業界の現在の問題は何ですか?

モデルの発明により生成人工知能技術は広く知られるようになりましたが、まだ大規模な商用実装のレベルには達していません。

Google、OpenAI、Stability などの企業の研究努力とエンジニアリングの努力がなければ、私たちは今日このような成功した生成 AI 技術を目の当たりにすることはできなかったでしょう。これまで見てきた新しいモデル アーキテクチャであれ、トレーニング パイプラインの拡張であれ、それは主に現在の大規模言語モデル (LLM) と画像モデルの強力な機能によるものです。

しかし、これらの企業の収益を見ると、これほど多くの利用量と市場の人気に比べて、収益はそれほど高くありません。画像生成に関しては、Stable Diffusion のコミュニティが爆発的に増加しました。しかし、Stability の主要なチェックポイントは開いており、それが Stability のビジネスの中核的な信条です。

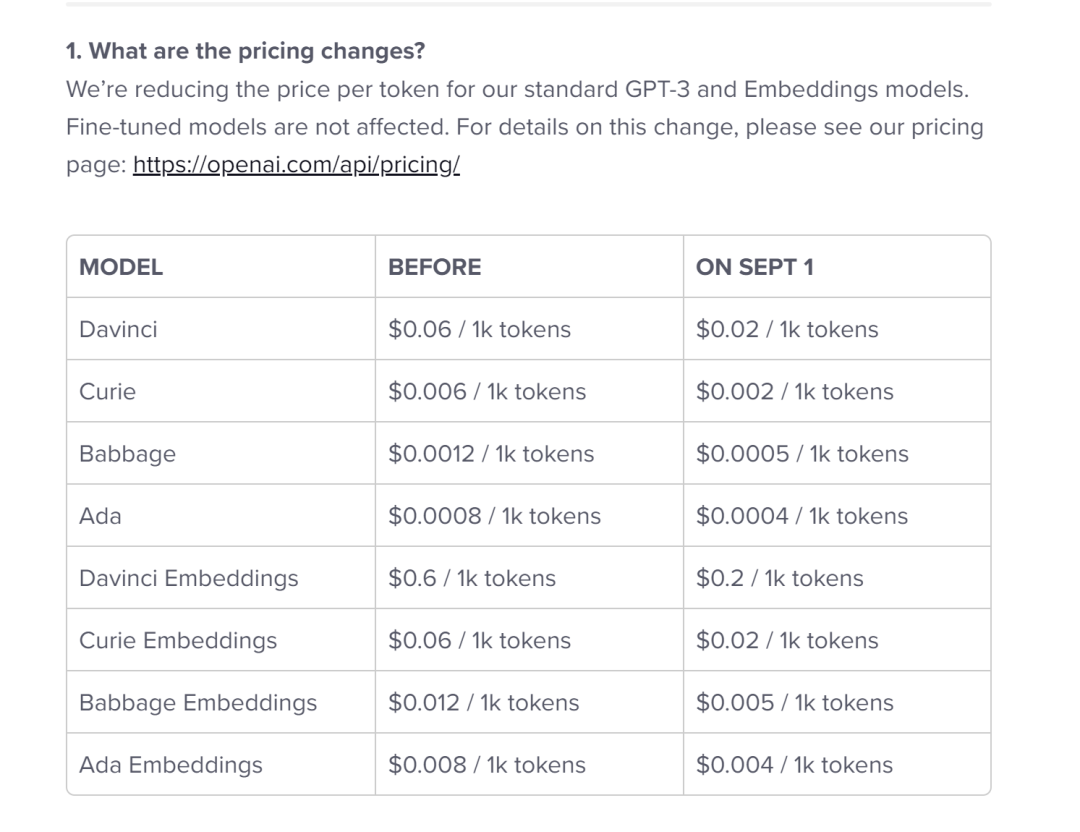

自然言語モデルに関しては、OpenAI は GPT-3/3.5 と ChatGPT で知られています。しかし、これまでのところ、OpenAI 上に構築されたキラーアプリは少なくなり、価格は一度下がっています。 (以下を参照してください)

(なぜ値下げしたのか考えてみませんか?)

もちろん、現時点ではこれらは一時的な現象にすぎない可能性があります。 Stability は新しいタイプのスタートアップであり、商業化に焦点を当てていません。 OpenAI は大規模なビジネスを展開する可能性があり、より多くのキラー アプリが構築されるにつれて、OpenAI は自然言語業界のすべてのカテゴリの収益のかなりの部分を獲得する可能性があります。特にMicrosoftのポートフォリオへのOpenAIの統合がうまくいけば、これらのモデルの利用率が高くなると巨額の収益につながる可能性がある。

しかし、隠れた危険もあります。

たとえば、モデルがオープンソースの場合、大規模モデルのトレーニング費用 (数千ドル、数億ドル) を負担しない他の企業を含め、誰でもホストできます。

そして、クローズドソースモデルがその優位性を無期限に維持できるかどうかは明らかではありません。たとえば、Anthropic、Cohere、Character.ai などの企業によって構築された大規模モデル LLM が OpenAI のパフォーマンス レベルに近づき、同様のデータセット (つまりインターネット) でトレーニングされ、同様のモデル アーキテクチャを採用しているのが見られ始めているとします。

安定拡散の例は、オープンソース モデルが一定レベルのパフォーマンスとコミュニティ サポートを達成した場合、同じ軌道にある他の代替モデルが競争するのが非常に困難になる可能性があることを示しています。

おそらく、これまでのところモデルプロバイダーにとって最も明白な利益は、ホスティングに関連した商業化です。(注:これは、前回の記事で述べたモデル全体と学習済みモデル(チェックポイントとも呼ばれます)の構築方法を公開するか、モデル全体と学習済みモデルの構築方法を秘密にすることを指します)公開されているインターフェース API は 1 つだけですが、前者の場合、トレーニング/微調整/推論を自分で実行する必要があるため、どのような環境でどのようなハードウェアで実行できるかを知る必要があるため、誰かが提供する必要がありますモデルのオペレーティング環境を処理するためのホスティング プラットフォーム);

そして、独自の API (OpenAI など) に対する需要が急速に高まっています。たとえば、オープンソースのモデル ホスティング サービス (Hugging Face や Replicate など) は、モデルを簡単に共有および統合するためのハブとして登場し、モデルの作成者と消費者の間に間接的なネットワーク効果を生み出すことさえあります。また、企業顧客との微調整やエスクロー契約を通じて、会社の収益性を達成することが可能であるという強い仮定もあります。

ただし、モデル プロバイダーは依然として問題に直面しています。

商品化する。AI モデルのパフォーマンスは時間の経過とともに収束するとの見方が一般的です。アプリ開発者と話をすると、テキスト モデルと画像モデルの両方でトップ プレーヤーが存在するため、これまでのところこのレベルの一貫したパフォーマンスは実現されていません。これらの企業の利点は、独自のモデル アーキテクチャにあるのではなく、高い資本要件、独自の製品相互作用データ、および希少な AI 人材に基づいています。

しかし、これらは企業にとって長期的に持続可能な利点となるでしょうか?

モデルベンダーから離脱するリスク。モデルのサプライヤーに依存することは、多くのアプリ企業がサプライヤーを利用してビジネスを開始し、成長させる方法でもありますが、一度規模が拡大すると、アプリ開発者は独自のモデルを構築および/またはホストするインセンティブが得られます。多くのモデル ベンダーは顧客の分布が不均一で、少数のアプリケーションが収益のほとんどを占めています。これらの顧客がサプライヤーのモデルを使用せず、独自の社内人工知能モデル開発に頼ったらどうなるでしょうか?

資本は重要ですか?生成 AI のビジョンは非常に優れているため、多くのモデル ベンダーがその使命に公益を組み込み始めています。これは彼らの資金繰りにまったく支障をきたしていません。しかし、議論する必要があるのは、モデルベンダーが本当に価値を獲得する意思があるのか、そしてそれを獲得すべきなのかということです。

インフラを手に入れて世界を手に入れましょう。

Generative AI のすべては、クラウドでホストされる GPU (または TPU) サービスを使用します。モデル ベンダーや研究機関、トレーニング ワークロードの実行、または推論/微調整を実行するホスティング会社のいずれであっても、FLOPS は生成 AI の鍵となります。

(Alpha Rabbit の研究ノートへの注: FLOPS とは、Floating point Operation per Second の略で、1 秒あたりの浮動小数点演算の回数を意味し、計算速度として理解されます。これはハードウェアのパフォーマンスを測定する指標です。通常、私たちが評価するときモデルを作成するには、まずその精度を見てください。精度が十分でない場合は、モデルの予測速度や展開時のメモリの小ささを他の人に伝えます。それは役に立ちません。しかし、モデルが一定の精度に達すると、程度に応じて、モデルを評価するにはさらなる評価指標が必要です。

これも:

1) 順伝播に必要な計算能力。GPU などのハードウェアのパフォーマンス要件を反映します。

2) 占有メモリ サイズを反映するパラメータの数。なぜこれら 2 つのインジケーターを追加するのでしょうか?これはモデル アルゴリズムの実装に関連しているためです。たとえば、深層学習モデルを携帯電話や自動車に導入したい場合、モデルのサイズとコンピューティング能力に関して厳しい要件があります。誰もがモデルパラメータが何であるか、そしてその計算方法を知っている必要がありますが、順伝播に必要な計算能力にはまだ少し疑問があるかもしれません。順伝播に必要な計算能力の合計は次のとおりです。それは FLOP によって具体化されます。

参考資料:Zhihu A Chai Ben Chai:https://zhuanlan.zhihu.com/p/137719986)

そのため、生成 AI の資金の多くがインフラ企業に流れ込むことになります。大まかに見積もると、アプリケーション企業は平均して、顧客あたりの推論と微調整に収益の約 20 ~ 40% を費やします。そして、その収益は通常、コンピューティング インスタンスのクラウド プロバイダーまたはサードパーティ モデル プロバイダーに直接支払われ、それらのプロバイダーは収益の約半分をクラウド インフラストラクチャに費やします。したがって、今日の生成 AI 収益の 10 ~ 20% がクラウド プロバイダーに支払われていると推測できます。

さらに、独自のモデルをトレーニングする新興企業もベンチャーキャピタルで数十億ドルを調達しており、そのほとんど(初期ラウンドでは最大80~90%)が通常クラウドプロバイダーに費やされます。多くのテクノロジー企業は、外部のクラウド プロバイダーまたはハードウェア メーカーと直接連携して、モデルのトレーニングに年間数億ドルを費やしています。

AIGC の初期の市場では、そのほとんどが次の 3 つの主要なクラウドに費やされます。アマゾン ウェブ サービス (AWS)、Google Cloud (GCP)、Microsoft Azure、これらのクラウド プロバイダーは、最も包括的で信頼性があり、コスト競争力の高いプラットフォームを確保するために、合わせて年間 1,000 億ドル以上の設備投資を行っています。

特に生成人工知能の分野では、これらのクラウド ベンダーは希少なハードウェア (Nvidia A 100 や H 100 GPU など) を優先することができます。

(Alpha Rabbit 注: 100 は次のようになります)

こちらの記事もお読みください:速報 | 米国がNVIDIAの一部製品の中国への販売を停止したことについての解釈 20220901

その結果、競争が生まれ、Oracle などの挑戦者、または Coreweave や Lambda Labs などの新興企業が、コスト、使いやすさ、個別サポートの点で大規模モデル開発者向けのソリューションを急成長させています。よりきめの細かいリソース抽象化 (つまり、コンテナー) が可能ですが、大規模なクラウドでは、GPU 仮想化の制限により仮想マシン インスタンスのみが提供されます。

[Alpha Rabbit の研究ノートへの注: たとえば、インターネット上で買い物をしたり、メッセージを送信したり、オンライン バンキングを利用したりするとき、私たちは皆、クラウドベースのサーバーと対話しています。つまり、クライアント (携帯電話、コンピュータ、iPad) を使用してさまざまな操作を実行する場合、サーバーにリクエストを送信する必要があり、各操作では対応するサーバーが各リクエストを処理して応答を返す必要があります。

何千人ものユーザーが同時に大量のリクエストと応答を行うには、強力なコンピューティング能力が必要です (Double イレブンで買い物をしていたときのことを考えてみてください。無数のユーザーが同時に注文を急いでいたため、ショッピング カートが突然停止してしまいました)。 、この 現時点では、計算能力が非常に重要です。前述したように、仮想マシンはコンピューティング機能の一部であり、クラウド サービス プロバイダーのクラウド コンピューティング ソリューションを使用する場合、企業の現在の機能とニーズに応じて仮想マシンの使用を選択できます。

仮想マシンとは何ですか?

これは、完全に分離されたシステムで実際のコンピュータの機能を提供できるコンピュータ システムのエミュレータです。システム仮想マシンは、私たちが使用している Windows システムなどの完全なオペレーティング システムを実行できる完全なシステム プラットフォームを提供できます。 MAC OSシステムなどプログラム仮想マシンは、エミュレータ内で独立して実行できるコンピュータ プログラムです。つまり、クラウド サービス プロバイダーが提供する仮想マシンを購入すると、クラウド サービス プロバイダーから土地を購入するようなもので、私たちと同じように、仮想マシン上でさまざまなソフトウェアをインストールし、さまざまなタスクを実行できるようになります。自分たちで買ったもので、ここに来た土地に家を建てるようなものです。

コンテナとは何ですか?容器は、通常、ご飯茶わん、食器、物を入れることができるその他の道具として理解されています。 IT分野でよく言われるコンテナ技術とは何でしょうか?実はこの言葉は Linux Container の訳語で、英語では Container という言葉には入れ物、コンテナという意味があります(専門的な比喩ではコンテナの主な意味はコンテナです)。ただし、中国語ではコンテナの方が読みやすいため、中国語のコンテナを一般的な単語として使用します。 Linux コンテナ技術を生き生きと理解したい場合は、これを読んだ後、頭の中で臨海貨物ターミナルのコンテナを想像することができます。

貨物ターミナルのコンテナは物資を運ぶために使用され、規格化された鋼製の箱です。コンテナの特徴は、すべて正方形で形式が統一されており、積み重ねることができることです。

これにより、巨大な貨物船にコンテナに商品を積み込むことができ、輸送が必要なメーカーはより迅速かつ便利に商品を配送できるようになり、コンテナの登場によりメーカーはより効率的な輸送サービスを提供できるようになります。この便利な輸送サービスでは、中国環境で使いやすいように、コンピュータの世界でコンテナのイメージの概念を引用しています。 】

私たちの意見では、これまでのところ生成 AI における最大の勝者は、AI ワークロードの大部分を実行している Nvidia です。2023 会計年度第 3 四半期における Nvidia のデータセンター GPU 収益 38 億ドルは、その大部分が生成 AI のユースケースに充てられました。

(GPU: グラフィックス プロセッシング ユニット (英語: Graphics Processing Unit、略称: GPU) は、ディスプレイ コア、ビジュアル プロセッサ、ディスプレイ チップとも呼ばれ、パーソナル コンピュータ、ワークステーション、ゲーム機、および一部のモバイル デバイス (タブレット コンピュータなど)、スマートフォンなど) は、マイクロプロセッサ上で画像およびグラフィックス関連のコンピューティング作業を実行します)

NVIDIA は、GPU エコシステムへの数十年にわたる投資と学術界での長期にわたる詳細なアプリケーションを通じて、このビジネスの周囲に強力な堀を構築してきました。最近の分析では、Nvidia の GPU がトップの AI チップ新興企業よりも 90 倍多く研究論文に引用されていることが判明しました。

もちろん、Google TPU、AMD Instinct GPU、AWS Inferentia および Trainium チップ、Cerebras、Sambanova、Graphcore などのスタートアップ企業など、他のハードウェア オプションも存在します。

Intel は、独自のハイエンド Habana チップと Ponte Vecchio GPU を搭載して市場に参入しました。しかしこれまでのところ、インテルの新チップのうち大きな市場シェアを獲得しているものはほとんどない。他の 2 つの注目すべき例外は、TPU が着実な普及コミュニティといくつかの大規模な GCP 取引で注目を集めている Google と、Nvidia GPU を含むここにリストされているすべてのチップを製造すると考えられている TSMC です (Intel は独自のファブと TSMC を使用して、チップを作ります)。

私たちが発見したこと: インフラストラクチャは収益性があり、永続的で、一見防御可能なスタックの層です

ただし、インフラストラクチャ企業が答える必要がある質問には次のようなものがあります。

ステートレスなワークロードについてはどうですか?

これが意味するのは、Nvidia GPU をどこでレンタルしても、同じであるということです。ほとんどの AI ワークロードはステートレスです。つまり、モデル推論には接続されたデータベースやストレージは必要ありません (注: モデルの重み自体を除き、外部ストレージやデータベースは必要ありません)。これは、AI ワークロードは従来のアプリケーション ワークロードよりもクラウドへの移行が簡単である可能性があることを意味します。この場合、クラウド プロバイダーは、顧客がより安価なオプションに走らないようにする粘着性をどのように作り出すのでしょうか?

チップがもう不足していない場合はどうなりますか?

GPU の供給が不足しているため、クラウド プロバイダーや Nvidia の価格設定は高価になる可能性があります。ベンダーによれば、A 100 の定価は発売以来上昇し続けており、これはコンピューティング ハードウェアとしては非常に異例のことです。では、生産の増加や新しいハードウェア プラットフォームの採用によって、最終的にこの供給制約が解消されると、クラウド プロバイダーはどうなるでしょうか?

シンジンユンは包囲を突破できるでしょうか?

私たちは、垂直型クラウドが、より特化した製品によってビッグ 3 から市場シェアを奪うと考えています。 AI 分野では、これまでのところ、新しいクラウド プレーヤーは、控えめなテクノロジーの差別化と Nvidia の支援によって勢いを増しています。たとえば、既存のクラウド プロバイダーは最大の顧客であると同時に、新たな競合他社でもあります。したがって、これらの新興クラウド企業にとっての長期的な問題は、3 つの巨人の規模の利点を克服できるかどうかです。

では、価値が最も蓄積されるのはどこでしょうか?最大の価値を獲得するにはどうやって投票すればよいでしょうか?

まだ明確な答えはありませんが、現在入手可能な生成 AI に関する初期のデータに基づいて、初期の AI および機械学習スタートアップの経験と組み合わせると、次のような判断が下されます。

今日の生成 AI には、いかなる意味でもシステム的な堀はほとんどありません。現在のアプリケーションを見ると、製品の差別化はあまりなく、その兆候は非常に明白です。その理由は、これらのアプリが同様の AI モデルを使用しているためです。したがって、現在のモデルが直面しているのは、長期的にはその違いがどこにあるのかを判断することが不可能であるということです。これらのモデルは、同様のデータセットとアーキテクチャでトレーニングされており、クラウドプロバイダーも同様であり、どのテクノロジーも基本的に同じです。というのは、同じ GPU を実行しているためであり、ハードウェア会社であっても同じ工場でチップを製造しているからです。

確かに、標準的な堀はまだ存在します。規模の堀が存在します。たとえば、同じスタートアップ企業、私はあなたより資金調達が良い、私の資金調達能力が強い、またはサプライ チェーンの堀、私は GPU を持っていますが、あなたは持っていません、またはエコシステムの堀などです。 、私のソフトウェアにはあなたより多くのユーザーがいて、私が早く始めた、時間とユーザースケールの壁がある、またはアルゴリズムの堀、たとえば、私のアルゴリズムはあなたのアルゴリズムよりも強力です。販売分野の堀、つまり商品の販売において私はあなたよりも優れています、私はチャネルのリーダーです、またはデータ分野の堀、たとえば、私はあなたより多くのデータを収集します。

しかし、これらの堀はどれも長期的な利点がなく、持続可能ではありません。また、これらのスタックのどこに強力で即時的なネットワーク効果が広がるのかを正確に判断するのは時期尚早です。

利用可能なデータに基づいて、生成 AI に長期的な勝者総取りの機会があるかどうかを判断するのは時期尚早です。

奇妙に聞こえるかもしれませんが、私たちにとってこれは良いニュースです。

市場全体の潜在的な規模が把握しにくいからこそ、ソフトウェアや皆さんの試みと密接に関係しています。私たちは多くのプレーヤーがこの市場に参加することを期待しており、誰もが生成 AI スタックのあらゆるレベルで良心をもって競争することになります。私たちは、水平方向にも垂直方向にも経営できる企業の成功を期待しています。

ただし、これは最終市場とユーザーによって決定されます。たとえば、最終製品の主な差別化要因が AI テクノロジー自体にある場合、垂直化 (つまり、ユーザー向けアプリケーションとネイティブ モデルとの緊密な統合) が勝つ可能性が高くなります。

そして、AI がより大規模なロングテール機能セットの一部である場合、おそらく水平化が本当のトレンドとなるでしょう。もちろん、時間が経つにつれて、より伝統的な堀、さらには真新しい堀の設置も見られるはずです。

いずれにしても、1 つ確かなことは、生成 AI が業界を変えつつあるということです。誰もが学び続け、多くの価値が解放され、その結果、テクノロジーの生態系が変化します。誰もが途中です。