深度解析去中心化AI推理:如何在安全與效能之間取得平衡

- 核心观点:去中心化AI推理可打破算力垄断。

- 关键要素:

- 利用闲置GPU算力降低AI成本。

- 区块链记录确保推理可验证。

- 声誉机制平衡安全与性能。

- 市场影响:挑战中心化云服务商定价权。

- 时效性标注:中期影响。

原文作者:Anastasia Matveeva- Gonka 協定共同創辦人

目錄

- 真正的“去中心化”

- 區塊鏈與推理驗證

- 實際運作方式

- 安全與效能的權衡

- 優化空間

當我們開始建立Gonka時,我們有一個願景:如果任何人都能運行AI 推理並因此獲得報酬,會怎麼樣?如果我們可以利用所有未被使用的運算能力,而不是依賴昂貴的中心化服務商,會怎麼樣?

目前的AI 格局由少數幾家大型雲端服務商主導:AWS、Azure 和Google Cloud 控制著全球大部分AI 基礎設施。這種中心化帶來了一些我們許多人親身經歷過的嚴重問題。少數公司控制AI 基礎設施意味著他們可以任意定價、審查不喜歡的應用,並造成單點故障。當OpenAI 的API 宕機時,成千上萬的應用隨之崩潰。當AWS 出現中斷時,半個網路都停止了運作。

即使是「高效」的前沿領域也不便宜。 Anthropic 曾表示訓練Claude 3.5 Sonnet 花費了“幾千萬美元”,而Claude Sonnet 4 現已普遍可用,Anthropic 尚未公佈其訓練成本。其執行長Dario Amodei 先前預測,前緣模型的訓練成本將接近10 億美元,而下一波模型將達到數十億美元。在這些模型上運行推理同樣不便宜。對於一個中等活躍度的應用來說,單次LLM 推理每天可能花費數百到數千美元。

同時,世界上有大量的運算能力被閒置(或以無意義的方式使用)。想想那些為了解決毫無價值的哈希謎題而消耗電力的比特幣礦工,或是運行容量未滿的資料中心。如果這些運算能力能夠用於真正有價值的事情,例如AI 推理,會怎麼樣?

去中心化方法可以將運算能力匯集起來,降低資本門檻,減少單一供應商瓶頸。我們不再依賴少數幾家大公司,而是可以創建一個網絡,讓任何擁有GPU 的人都能參與其中,並透過運行AI 推理獲得報酬。

我們知道,建立一個可行的去中心化解決方案將非常複雜。從共識機製到訓練協議再到資源分配,有無數個需要協調的部分。今天我想重點討論其中一個面向:運行特定LLM 的推理。這究竟有多難?

什麼是真正的“去中心化”

當我們談論去中心化的AI 推理時,我們指的是一個非常具體的東西。它不僅僅是讓AI 模型在多台伺服器上運行,而是要建立一個系統,讓任何人都可以加入,貢獻算力,並因誠實工作而獲得獎勵。

關鍵要求是系統必須是無信任的。這意味著你不必信任任何個人或公司來正確運作系統。如果你要讓網路上的陌生人來運行你的AI 模型,你需要有密碼學上的保證,來確保他們確實在做他們聲稱在做的事情(至少要有足夠高的機率)。

這個無信任的要求帶來了一些有趣的含義。首先,這意味著系統需要可驗證:你需要能夠證明,用於產生給定輸出的是同一個模型和相同的參數。這對於需要驗證其所獲得的AI 回應是否合法的智能合約尤其重要。

但這有一個挑戰:你添加的驗證越多,整個系統就越慢,因為網路的算力被消耗在驗證上。如果你完全信任所有人,就不需要驗證推理,效能幾乎和中心化服務商一樣。但如果你不信任任何人,總是要驗證一切,系統就會變得非常慢,無法與中心化解決方案競爭。

這就是我們一直在努力解決的核心矛盾:在安全與效能的權衡中找到正確的平衡。

區塊鏈與推理驗證

那麼,如何實際驗證某人運行了正確的模型和參數?區塊鏈成為了一個顯而易見的選擇——儘管它也有自己的挑戰,但它仍然是我們所知的創建不可篡改事件記錄的最可靠方式。

基本思想相當直接。當有人在運行推理時,他們需要提供使用正確模型的證明。這個證明被記錄在區塊鏈上,創造了一個永久的、防篡改的記錄,任何人都可以驗證。

問題是區塊鏈很慢。真的非常慢。如果我們試圖將推理的每一步都記錄在鏈上,龐大的資料量會很快癱瘓網路。這正是我們在設計Gonka 網路時,驅動了許多決策的限制條件。

在設計網路和思考分散式運算時,有多種策略可供選擇。你可以將模型分片到多個節點上,還是讓完整的模型駐留在一個節點中?主要的限制來自網路頻寬和區塊鏈速度。為了使我們的解決方案可行,我們選擇了讓一個完整模型適配一個節點,儘管這在未來可能會改變。這確實對加入網路增加了最低要求,因為每個節點需要足夠的運算能力和記憶體來運行整個模型。儘管如此,模型仍然可以在屬於同一節點的多個GPU 之間進行分片,這給了我們在單節點限制內一些靈活性。我們使用vLLM,它允許自訂張量和管線並行參數以實現最佳效能。

實際運作方式

因此,我們達成一致:每個節點託管一個完整的模型並運行完整的推理,從而避免了在實際計算過程中需要跨多台機器進行協調。區塊鏈僅用於記錄。我們只記錄用於推理驗證的交易和工件(artifacts)。實際計算發生在鏈下。

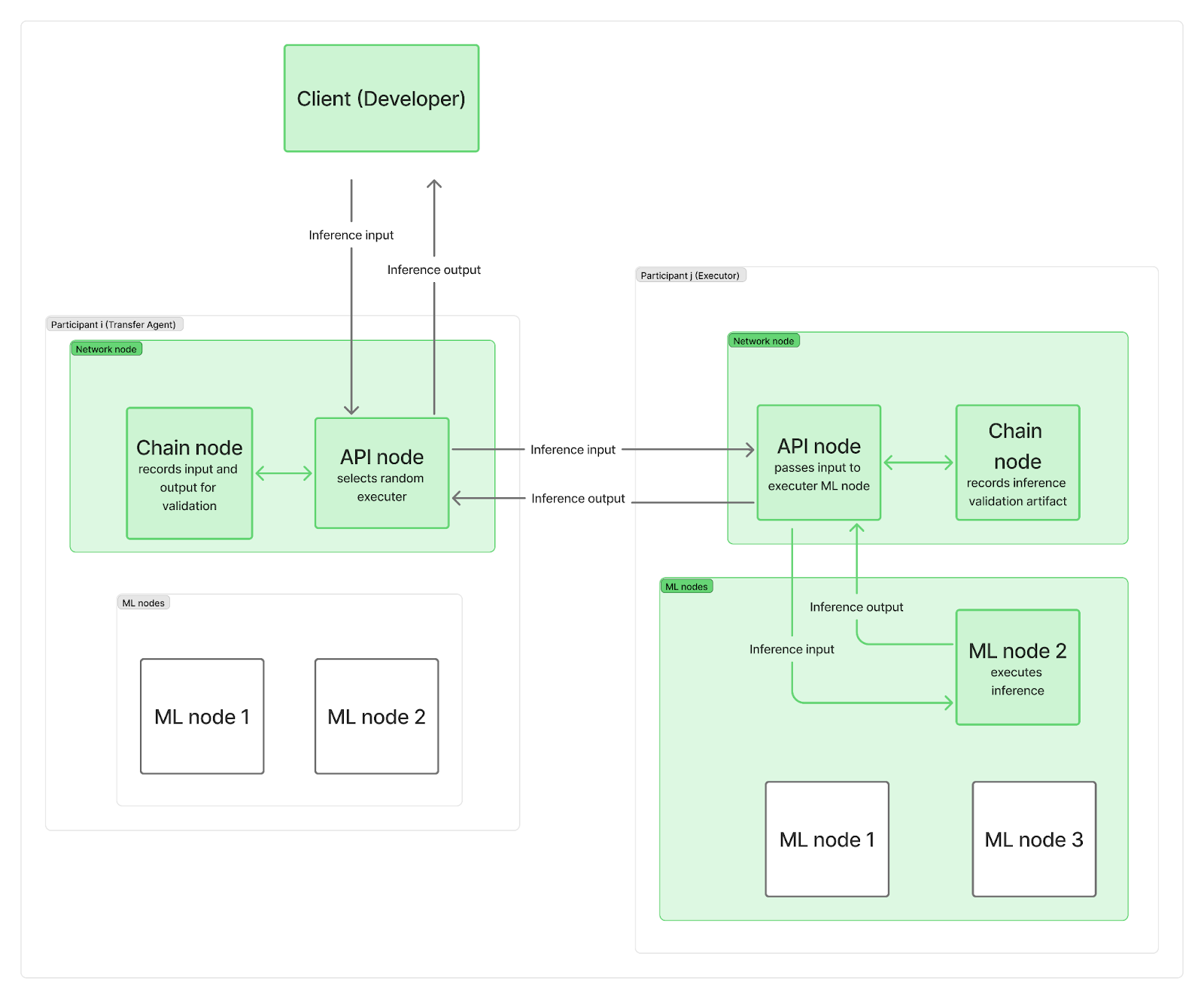

我們希望系統是去中心化的,沒有任何單一中心點來指揮推理請求到網路節點。實際上,每個參與者至少部署兩個節點:一個網路節點和一個或多個推理(ML)節點。網路節點負責通訊(包括一個連接到區塊鏈的鏈節點和一個管理用戶請求的API 節點),而你的ML 節點則執行LLM 推理。

當推理請求到達網路時,它會到達其中一個API 節點(充當「傳輸代理」),該代理會隨機選擇一個「執行者」(來自不同參與者的ML 節點)。為了節省時間並將區塊鏈記錄與實際LLM 計算並行化,傳輸代理(TA)首先將輸入請求發送給執行者,並在執行者的ML 節點正在運行推理時,將輸入記錄在鏈上。計算完成後,執行者將輸出傳送給TA 的API 節點,同時其自身的鏈節點會將某個驗證工件記錄在鏈上。 TA 的API 節點會將輸出傳回給客戶端,並且同樣記錄在鏈上。當然,這些記錄仍然會造成整體網路頻寬限制。

正如你所看到的,區塊鏈記錄既沒有拖慢推理計算的開始,也沒有拖慢最終結果回傳給客戶端的時間。推理是否誠實地完成的驗證是在之後,與其他推理並行進行的。如果執行者被發現作弊,他們將失去整個紀元的獎勵,而客戶端會收到通知並獲得退款。

最後的問題是:工件包含了什麼,以及我們多久驗證一次推理?

安全與效能的權衡

根本的挑戰是,安全與性能是相互矛盾的。

如果你想要最大的安全性,你需要驗證一切。但這既慢又昂貴。如果你想要最大的效能,你就需要信任所有人。但這有風險,並會讓你面臨各種攻擊。

經過一番嘗試、錯誤和參數調整後,我們找到了一種試圖平衡這兩種考慮的方法。我們必須仔細調整驗證的量、驗證的時間以及如何使驗證過程盡可能有效率。驗證太多,系統將變得無法使用;驗證太少,系統則變得不安全。

保持系統輕量化至關重要。我們必須透過儲存前k個下一個token 的機率來保持工件的輕量性。我們用它們來衡量某個輸出是否確實是由聲稱的模型和參數產生的可能性,並以足夠高的置信度捕捉任何篡改行為,例如使用較小的模型或量化模型。我們將在另一篇文章中更詳細地介紹推理驗證程序的具體實作。

同時,如何決定驗證哪些推理、不驗證哪些?我們選擇了基於聲譽的方法。當一個新參與者加入網路時,他們的聲譽為0,他們100% 的推理都將至少被一個參與者驗證。如果發現問題,最終會使用共識機制來確定是否通過你的推理,或降低你的聲譽,並可能將你踢出網路。隨著你的聲譽成長,需要驗證的推理數量會減少,最終可能隨機抽選1%的推理進行驗證。這種動態方法使我們能夠保持整體驗證百分比較低,同時有效捕捉那些試圖作弊的參與者。

參與者在每個紀元結束時,根據他們在網路中的權重按比例獲得報酬。任務也按權重分配,因此報酬預計會與權重和完成的工作量成比例。這意味著我們不需要立即抓住並懲罰詐欺者,在發放報酬前,在本紀元內抓住他們就足夠了。

經濟誘因驅動這種權衡的程度不亞於技術參數。透過讓作弊的成本高昂,而誠實參與有利可圖,我們可以創造一個理性的選擇是誠實參與的系統。

優化空間

經過數月的構建和測試,我們已經建立了一個系統,它結合了區塊鏈在記錄和安全性方面的優勢,同時在單次推理性能上接近中心化服務商。安全與效能之間的根本矛盾是真實存在的,沒有完美的解決方案,只有不同的權衡。

我們相信,隨著網路的擴展,它在保持完全去中心化社區控制的同時,有真正的機會與中心化服務商競爭。隨著它的發展,還有很大的優化空間。如果你有興趣了解這個過程,請訪問我們的GitHub 和文檔,加入我們的Discord 社群參與討論,並親自加入這個網路。

關於Gonka.ai

Gonka 是一個旨在提供高效AI 算力的去中心化網絡,其設計目標是最大限度地利用全球GPU 算力,完成有意義的AI 工作負載。透過消除中心化守門人,Gonka 為開發者和研究人員提供了無需許可的算力資源訪問,同時透過其原生代幣GNK 獎勵所有參與者。

Gonka 由美國AI 開發商Product Science Inc. 孵化。該公司由Web 2 產業資深人士、前Snap Inc. 核心產品總監Libermans 兄妹創立,並於2023 年成功融資1,800 萬美元,投資者包括OpenAI 投資方Coatue Management、Solana 投資方Slow Ventures、K 5、Insight and Benchmark 合夥人等。計畫的早期貢獻者包括6 blocks、Hard Yaka、Gcore 和Bitfury 等Web 2-Web 3 領域的知名領導企業。