X's New Algorithm Revealed: Likes Are Almost Worthless, This Action's Value Skyrockets 150 Times

- Core Viewpoint: X (formerly Twitter) has open-sourced its new recommendation algorithm, Phoenix. The core change is a shift from the old algorithm reliant on manually defined features to a model entirely driven by a large AI model (Grok transformer). It ranks content by predicting 15 types of user interaction behaviors, significantly altering the underlying logic of content distribution.

- Key Elements:

- Algorithm Architecture Innovation: The new Phoenix completely abandons manual feature engineering, instead using the Grok transformer model to predict and recommend content based on sequences of user historical behaviors (such as liking, replying, blocking).

- Content Ranking Mechanism: The algorithm predicts the probability of 15 potential positive (e.g., reply, retweet) and negative (e.g., report, block) user behaviors towards content, then calculates a weighted sum to determine the final ranking score.

- Creator Strategy Shift: Old tricks like "best time to post" become ineffective. Creators are encouraged to actively reply to comments (which carries extremely high weight), avoid triggering negative user behaviors like blocking, and are advised to place external links in comments rather than the main post body.

- Transparency and Limitations: While the open-source release provides the complete system architecture and logic, it does not disclose specific weight parameters, the model's internal parameters, or training data, leaving a gap from "full transparency."

原文作者:David,深潮 TechFlow

1 月 20 日下午,X 开源了新版推荐算法。

Musk 配的回复挺有意思:「我们知道这算法很蠢,还需要大改,但至少你能看到我们在实时挣扎着改进。别的社交平台不敢这么干。」

这话有两层意思。一是承认算法有问题,二是拿「透明」当卖点。

这是 X 第二次开源算法。2023 年那版代码三年没更新,早就和实际系统脱节了。这次完全重写,核心模型从传统机器学习换成了 Grok transformer,官方说法是「彻底消除了手工特征工程」。

翻译成人话:以前的算法靠工程师手动调参数,现在让 AI 直接看你的互动历史来决定推不推你的内容。

对内容创作者来说,这意味着以前那套「几点发帖最好」「带什么 tag 涨粉」的玄学可能不灵了。

我们也翻了翻开源的 Github 仓库,在 AI 的辅助下,发现代码里确实藏着一些硬逻辑,值得扒一扒。

算法逻辑变化:从手工定义,到 AI 自动判断

先说清楚新旧版本的区别,不然后面的讨论容易混。

2023 年,推特开源的那版叫 Heavy Ranker,本质就是传统机器学习。工程师要手动定义几百个「特征」:这条帖子有没有图、发帖人粉丝多少、发布时间离现在多久、帖子里有没有链接...

然后给每个特征配权重,调来调去,看哪个组合效果好。

这次开源的新版叫 Phoenix,架构完全不同,你可以理解成一个更加依赖 AI 大模型的算法,核心是用 Grok 的 transformer 模型,和 ChatGPT、Claude 用的是同一类技术。

官方 README 文档里写得很直白:「We have eliminated every single hand-engineered feature。」

传统那种靠手工提取内容特征的规则,一个不剩,全砍了。

那现在,这个算法靠什么判断一个内容到底好不好?

答案是靠你的行为序列。你过去点赞过什么、回复过谁、在哪些帖子上停留超过两分钟、屏蔽过过哪类账号。Phoenix 把这些行为喂给 transformer,让模型自己学出规律并进行总结。

打个比方:旧算法像一张人工编写的评分表,每项打勾算分;

新算法像一个看过你所有浏览记录的 AI,直接猜你下一秒想看什么。

对创作者来说,这意味着两件事:

第一,以前那些「最佳发帖时间」「黄金标签」之类的技巧,参考价值变低了。因为模型不再看这些固定特征,它看的是每个用户的个人偏好。

第二,你的内容能不能被推出去,越来越取决于「看到你内容的人会怎么反应」。这个反应被量化成了 15 种行为预测,我们下一章细说。

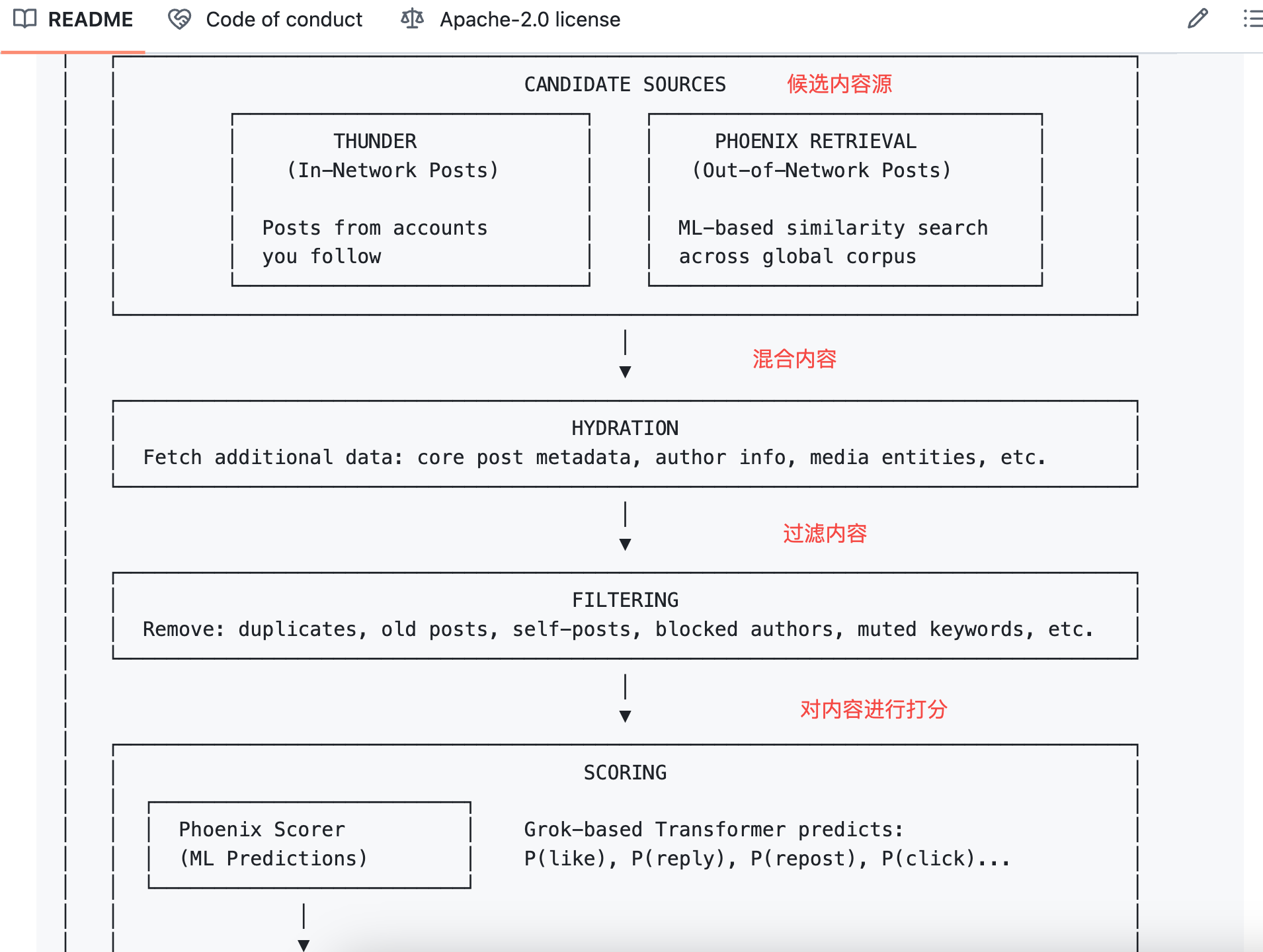

算法在预测你的 15 种反应

Phoenix 拿到一条待推荐的帖子后,会预测当前用户看到这条内容可能产生的 15 种行为:

- 正向行为:如点赞、回复、转发、引用转发、点击帖子、点击作者主页、看完一半以上视频、展开图片、分享、停留超过一定时长、关注作者

- 负向行为:如点「不感兴趣」、Block 作者、Mute 作者、举报

每种行为对应一个预测概率。比如模型判断你有 60% 概率点赞这条帖子、5% 概率屏蔽这个作者等等。

然后算法做一件简单的事:把这些概率乘以各自的权重,加起来,得到一个总分。

公式长这样:

Final Score = Σ ( weight × P(action) )

正向行为的权重是正数,负向行为的权重是负数。

总分高的帖子排前面,低的沉下去。

跳出公式,其实说白了就是:

现在一个内容好不好,真的不由内容本身写的好不好决定了(当然可读性和利他性是传播的基础);而是更多的取决于「这条内容会让你做出什么反应」。算法不在乎帖子本身的质量,它只在乎你的行为。

按这个思路想,极端情况下一条低俗但让人忍不住回复吐槽的帖子,得分可能比一条优质但没人互动的帖子更高。这套系统的底层逻辑或许就是如此。

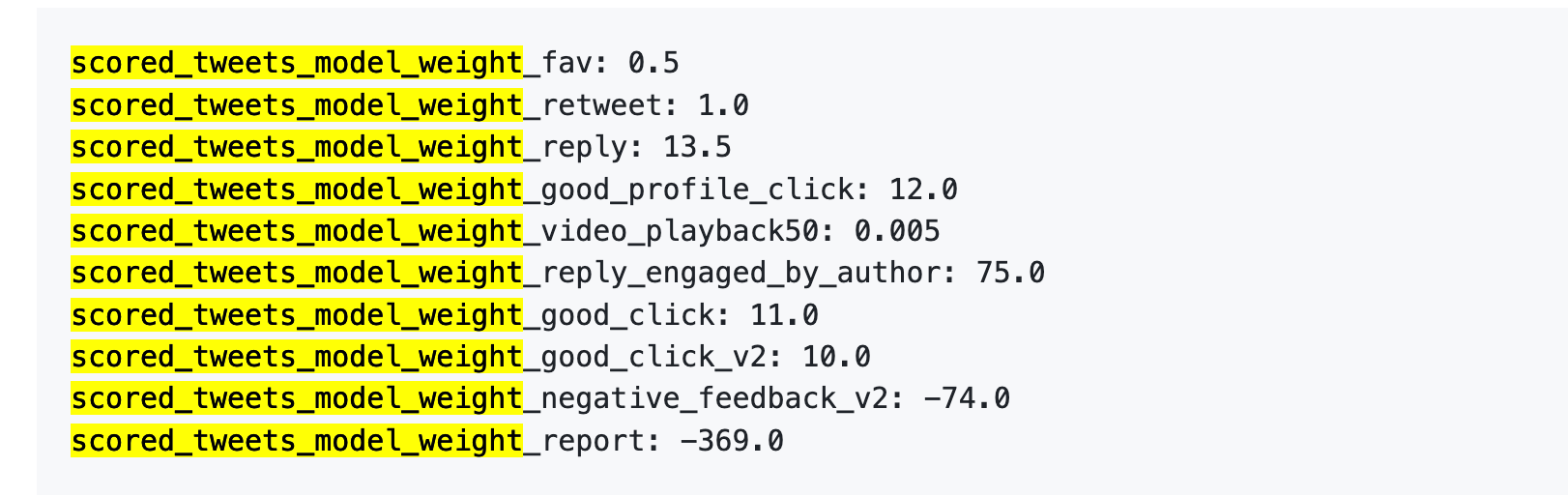

不过,新开源版本的算法没公开具体行为权重的数值,但 2023 年那版公开过。

旧版参考:一次举报 = 738 次点赞

接下来我们可以扒一下 23 年的那组数据,虽然是旧的,但能帮你理解各种行为在算法眼里的「价值」差多少。

2023 年 4 月 5 日,X 确实在 GitHub 上公开过一组权重数据。

直接上数字:

翻译的再直白一些:

数据来源:旧版 GitHub twitter/the-algorithm-ml 仓库,点击可以查看原算法

几个数字值得细看。

第一,点赞几乎不值钱。 权重只有 0.5,是所有正向行为里最低的。算法眼里,一个点赞的价值约等于零。

第二,对话互动才是硬通货。 「你回复,作者又回复你」的权重是 75,是点赞的 150 倍。算法最想看到的不是单向的赞,而是来回的对话。

第三,负向反馈代价极高。 一次 Block 或 Mute(-74)需要 148 次点赞才能抵消。一次举报(-369)需要 738 次点赞。而且这些负分会累积到你的账号信誉分里,影响后续所有帖子的分发。

第四,视频完播率权重低得离谱。 只有 0.005,几乎可以忽略。这和抖音、TikTok 形成鲜明对比,那两个平台把完播率当核心指标。

官方在同一份文件里也写了:「The exact weights in the file can be adjusted at any time... Since then, we have periodically adjusted the weights to optimize for platform metrics.」

权重随时可能调,而且确实调过。

新版本没公开具体数值,但 README 里写的逻辑框架一样:正向加分,负向扣分,加权求和。

具体数字可能变了,但量级关系大概率还在。你回复别人的评论,比收到 100 个赞更有用。让人想 Block 你,比没人互动更糟糕。

知道这些后,我们创作者能做什么

扒完推特的新旧算法代码,结合来看,提炼几条可操作的结论。

1.回复你的评论者。 权重表里「作者回复评论者」是最高分项(+75),比用户单方面点赞高 150 倍。不是让你去求评论,而是有人评论了就回。哪怕回一句「谢谢」,算法也会记一笔。

2.别让人想划走。 一次 block 的负面影响需要 148 次点赞才能抵消。争议内容确实容易引发互动,但如果互动方式是「这人烦死了,block」,你的账号信誉分会持续受损,影响后续所有帖子的分发。争议流量是双刃剑,砍别人之前先砍自己。

3.外链放评论区。 算法不想把用户导出站外。正文带链接会被降权,这点 Musk 自己公开说过。想导流的话,正文写内容,链接扔第一条评论。

4.别刷屏。 新版代码里有个 Author Diversity Scorer,作用是给同一作者连续出现的帖子降权。设计意图是让用户的 feed 更多样,副作用是你连发十条不如精发一条。

6.没有「最佳发帖时间」了。 旧版算法有「发布时间」这个人工特征,新版说砍就砍了。Phoenix 只看用户行为序列,不看帖子是几点发的。那些「周二下午三点发帖效果最好」的攻略,参考价值越来越低。

以上是代码层面能读出来的东西。

还有一些加分减分项来自 X 的公开文档,不在这次开源的仓库里:蓝标认证有加成、全大写会被降权、敏感内容触发 80% 触达率削减。这些规则没开源,就不展开了。

总结来看,这次开源的东西挺实在。

完整的系统架构、候选内容的召回逻辑、排序打分的流程、各种过滤器的实现。代码主要是 Rust 和 Python,结构清晰,README 写得比很多商业项目都详细。

但有几样关键的东西没放出来。

1.权重参数没公开。 代码里只写了「正向行为加分,负向行为扣分」,具体点赞值多少分、block 扣多少分,没说。2023 年那版至少把数字亮出来了,这次只给了公式框架。

2.模型权重没公开。 Phoenix 用的是 Grok transformer,但模型本身的参数没放。你能看到模型怎么被调用,看不到模型内部怎么算的。

3.训练数据没公开。 模型是用什么数据训出来的、用户行为怎么采样、正负样本怎么构造,都没说。

打个比方,这次开源相当于告诉你「我们用加权求和算总分」,但没告诉你权重是多少;告诉你「我们用 transformer 预测行为概率」,但没告诉你 transformer 里面长什么样。

横向比较的话,TikTok 和 Instagram 连这些都没公开过。X 这次开源的信息量,确实比其他主流平台多。只是离「完全透明」还有距离。

这不是说开源没有价值。对创作者和研究者来说,能看到代码总比看不到强。